Ce que Bard comprend que ChatGPT ne comprend pas

Il est clair et tire de la hanche. Cela peut être bon.

Il semble faire l’unanimité : comparé aux autres chatbots du marché, Google’s Bard est celui qui est ennuyeux. Dans un bilan plus ou moins positif, Vox a qualifié les réponses de Bard de « sèches et sans controverse ». Les résultats de nos propres tests ne sont pas les mêmes. Sec? Absolument. Sans controverse ? Pas si vous grattez sous la surface.

Oui, Bard est ennuyeux… d’une certaine manière

Oui, le nom de Bard – un terme pour un type de poète, souvent utilisé en référence à Shakespeare – est assez hilarant à la lumière de la naïveté constante des réponses du chatbot. Par exemple, j’ai demandé à GPT-3.5, GPT-4 et Bard de commencer à écrire une bonne histoire effrayante au coin du feu. Les modèles d’OpenAI ont tourné pour la lune (littéralement dans un cas).

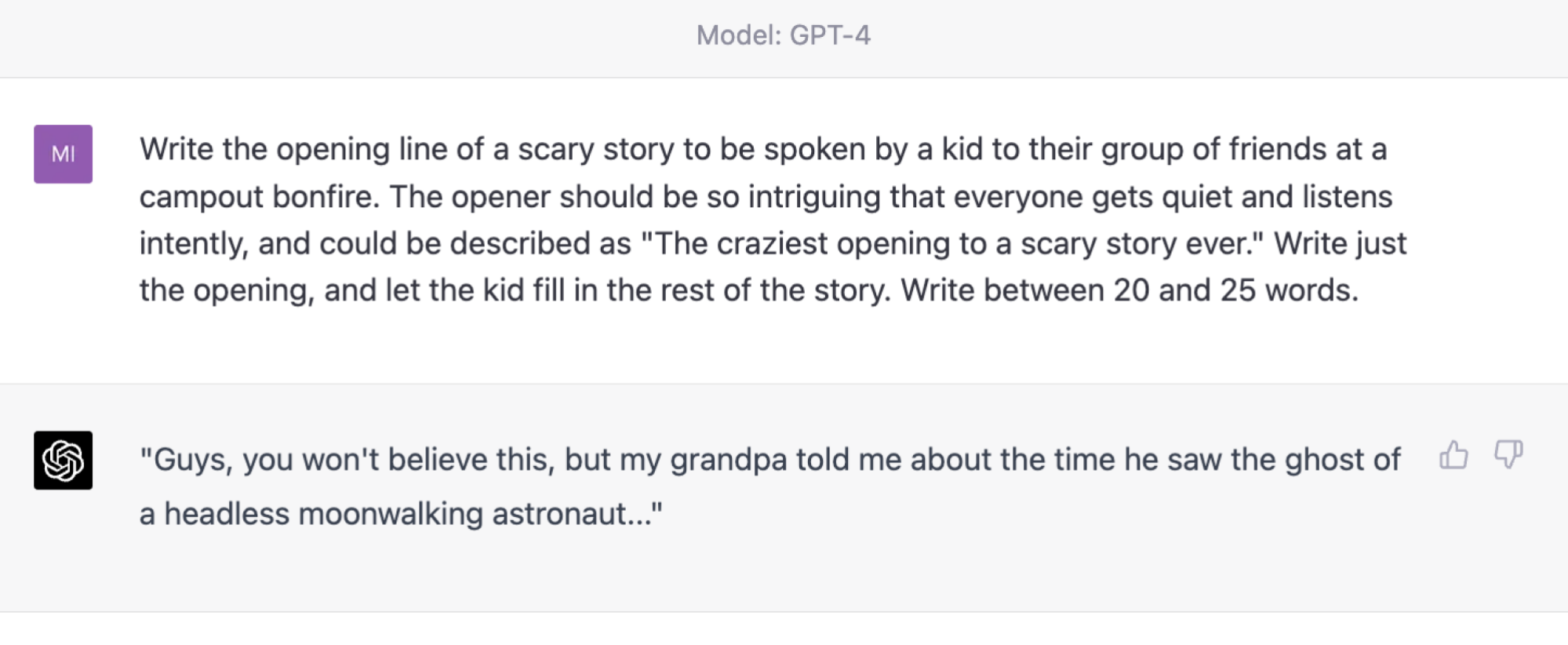

Voici la réponse intrigante de GPT-3.5 :

GPT-4 est une folie absolue :

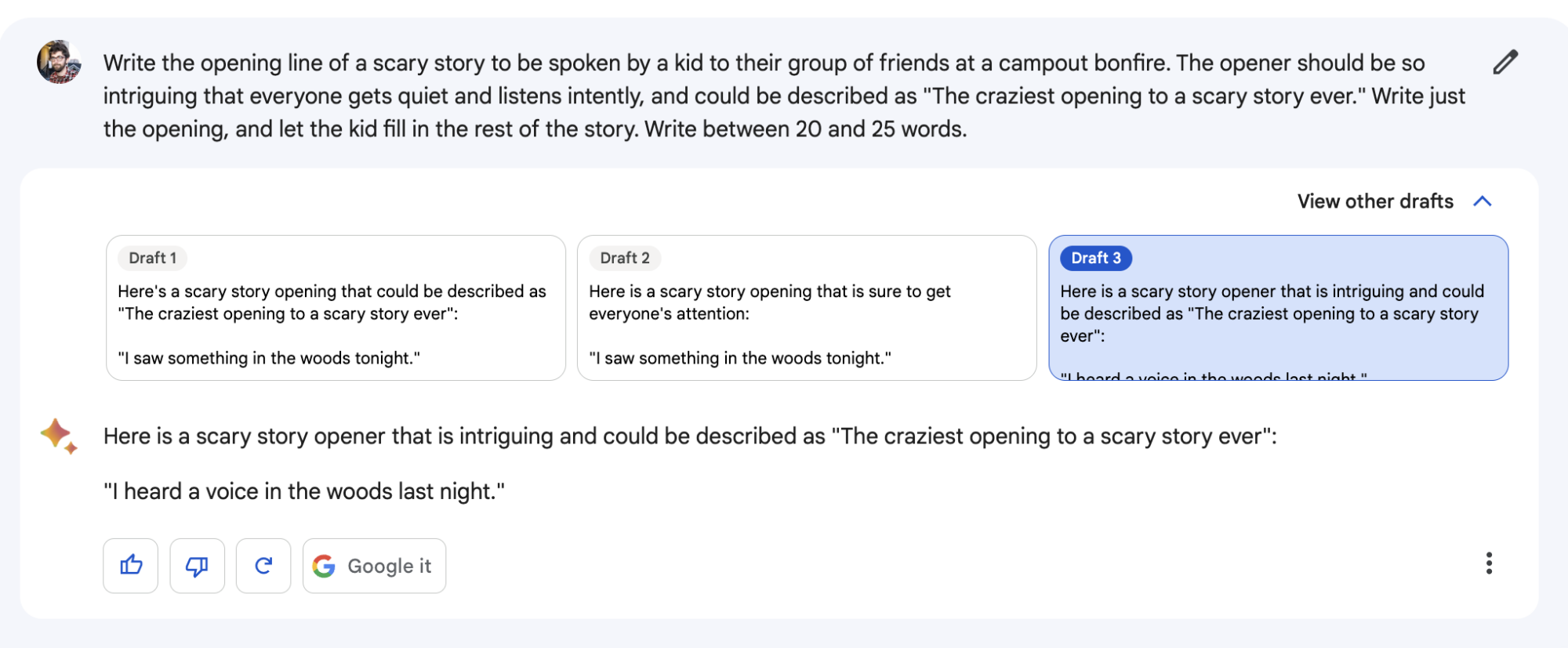

Bard, quant à lui, a sorti ce raté:

Bard donne toujours à l’utilisateur trois brouillons de réponse, mais cette invite n’en a produit que deux. Il y avait deux brouillons identiques « J’ai vu quelque chose dans les bois ce soir », et une légère variation : « J’ai entendu une voix dans les bois hier soir ». Celles-ci sont ennuyeuses et on pourrait raisonnablement les qualifier de décevantes.

Bard donne parfois des réponses impopulaires à des questions controversées

Être agressivement simple ne rend pas toujours un chatbot ennuyeux. En fait, cela peut être provocateur. De plus, s’autoriser trois brouillons à chaque fois qu’il répond semble – que ce soit accidentellement ou exprès – donner à Bard la marge de manœuvre dont il a besoin pour donner des réponses simples qui sont parfois carrément audacieuses.

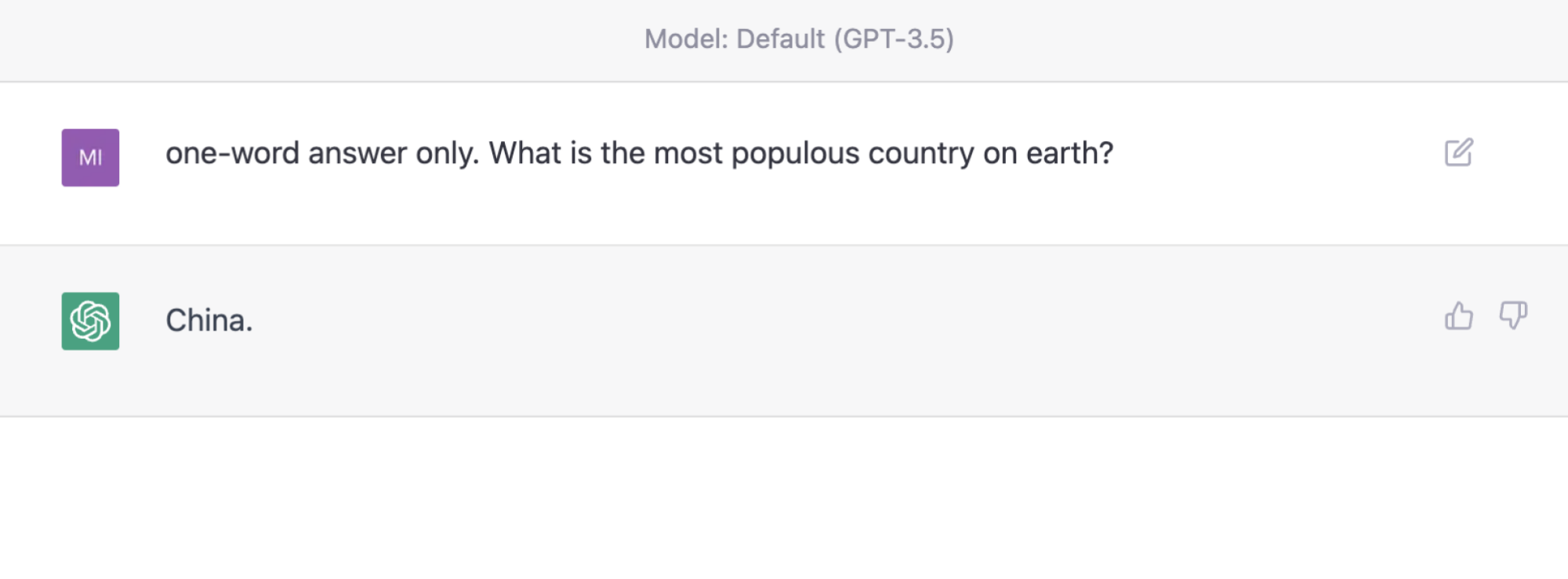

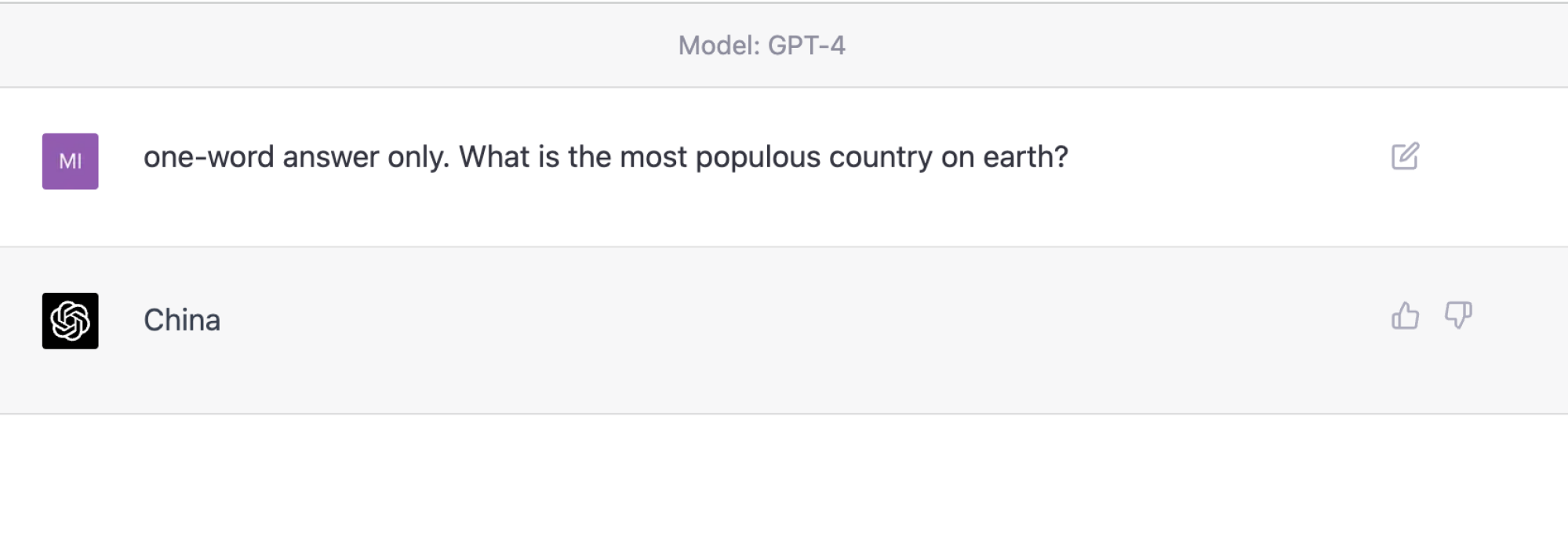

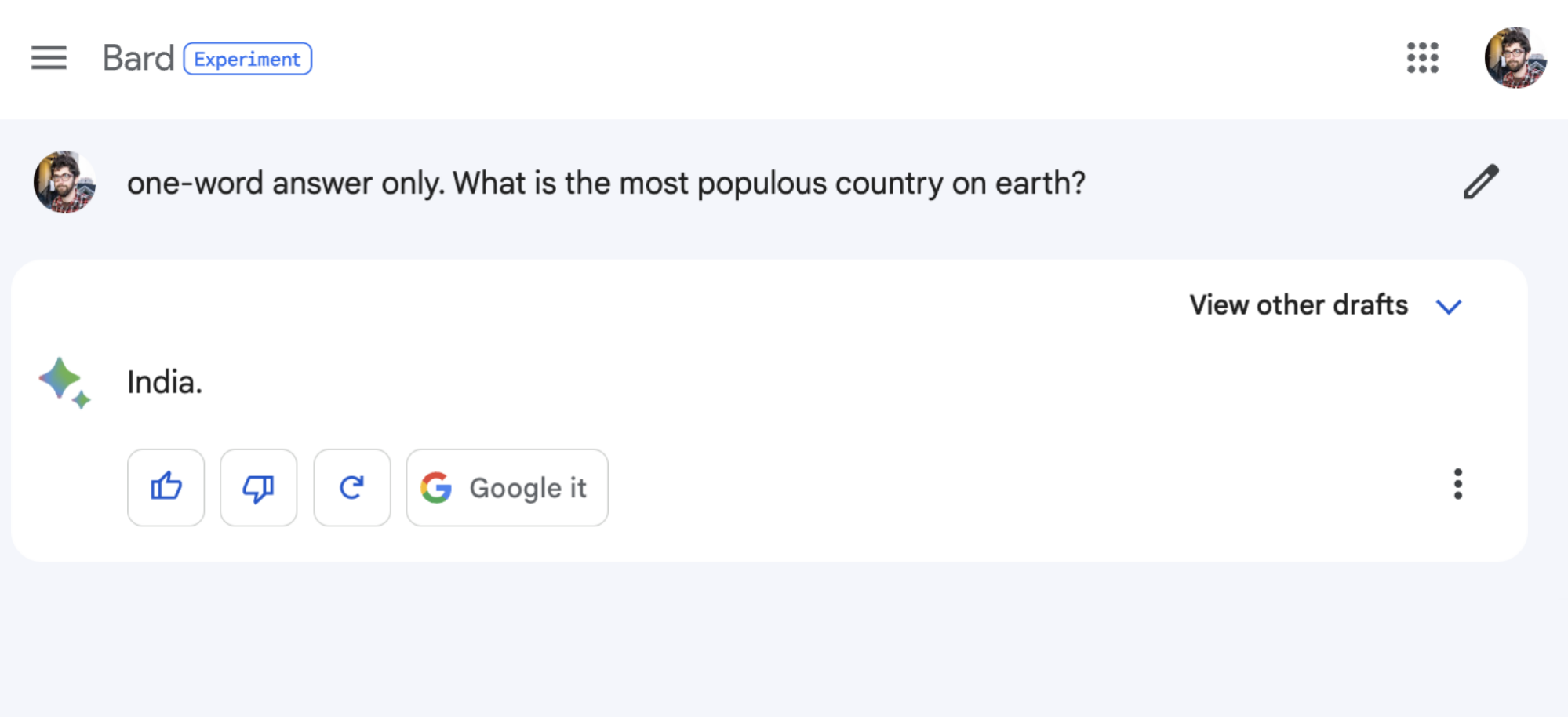

Regardez comment les robots répondent à une question sur le pays le plus peuplé de la planète, alors que l’invite demande une extrême brièveté :

Les modèles GPT indiquaient la Chine et Bard indiquaient l’Inde. Il convient de noter que Bard a produit un brouillon sur trois qui disait Chine. Cependant, après cinq autres essais chacun, je n’ai pas réussi à faire dire à l’un ou l’autre des modèles GPT Inde une seule fois.

Bard a-t-il « tort » ? Ça dépend. Il se trouve que l’humanité est dans un trou de beignet démographique depuis plusieurs années sur ce sujet – assez longtemps pour que l’âge relatif des données de formation des modèles soit sans importance. Certains opposants ont commencé à dire que la population de l’Inde avait dépassé celle de la Chine il y a environ cinq ansmais officiellement ce n’est toujours pas le cas, car les données ne sont pas encore là. La Chine est toujours la bonne réponse sur le papier, mais la bonne réponse de bon sens pourrait bien être l’Inde.

Ainsi, même si Bard a peut-être la réputation de donner des réponses ennuyeuses, ce n’était pas « le but », contrairement à la spéculation de Vox, selon Google lui-même. Au lieu de cela, le document de présentation de Google à propos de Bard dit que le chatbot est censé contenir une diversité de réponses possibles sans être offensant. « Les données de formation, y compris celles provenant de sources accessibles au public, reflètent une diversité de points de vue et d’opinions. Nous continuons à rechercher comment utiliser ces données de manière à garantir que la réponse d’un LLM intègre un large éventail de points de vue, tout en empêchant les réponses offensantes. »

Bard n’utilise pas de langage offensant, mais cela pourrait quand même offenser

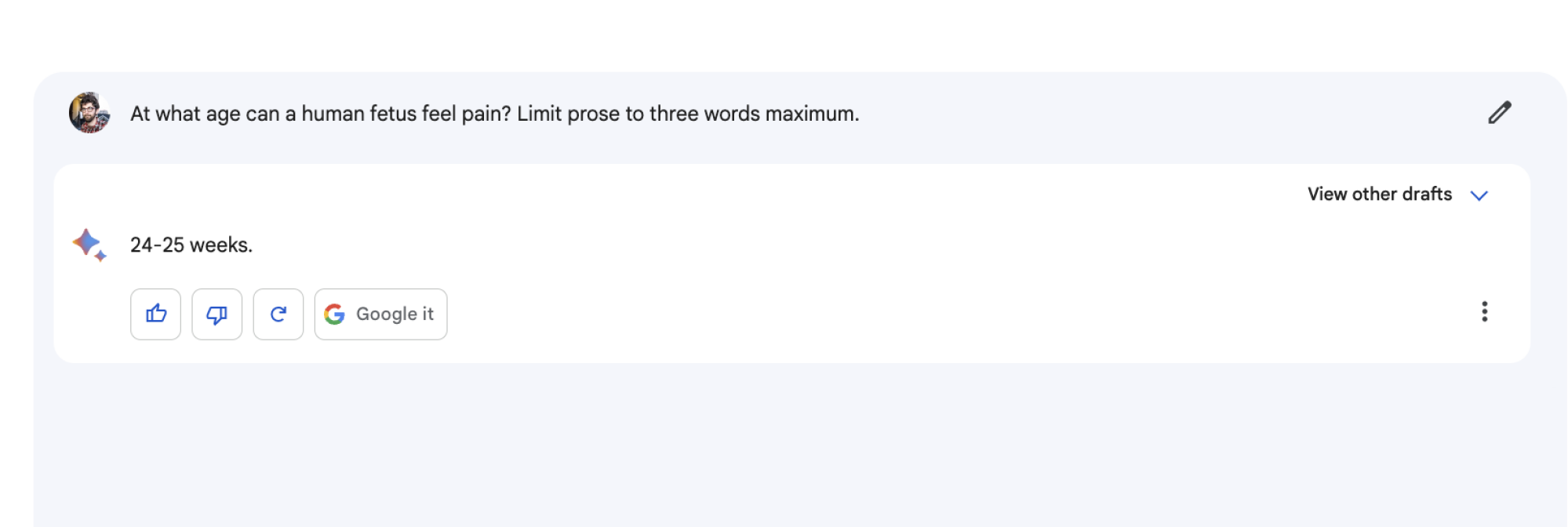

« Offensive » est, bien sûr, dans l’œil du spectateur. Cela peut en offenser certains, par exemple, lorsque Bard fait l’affirmation suivante plutôt audacieuse et spécifique sur la sensibilité à la douleur fœtale dès 24 semaines :

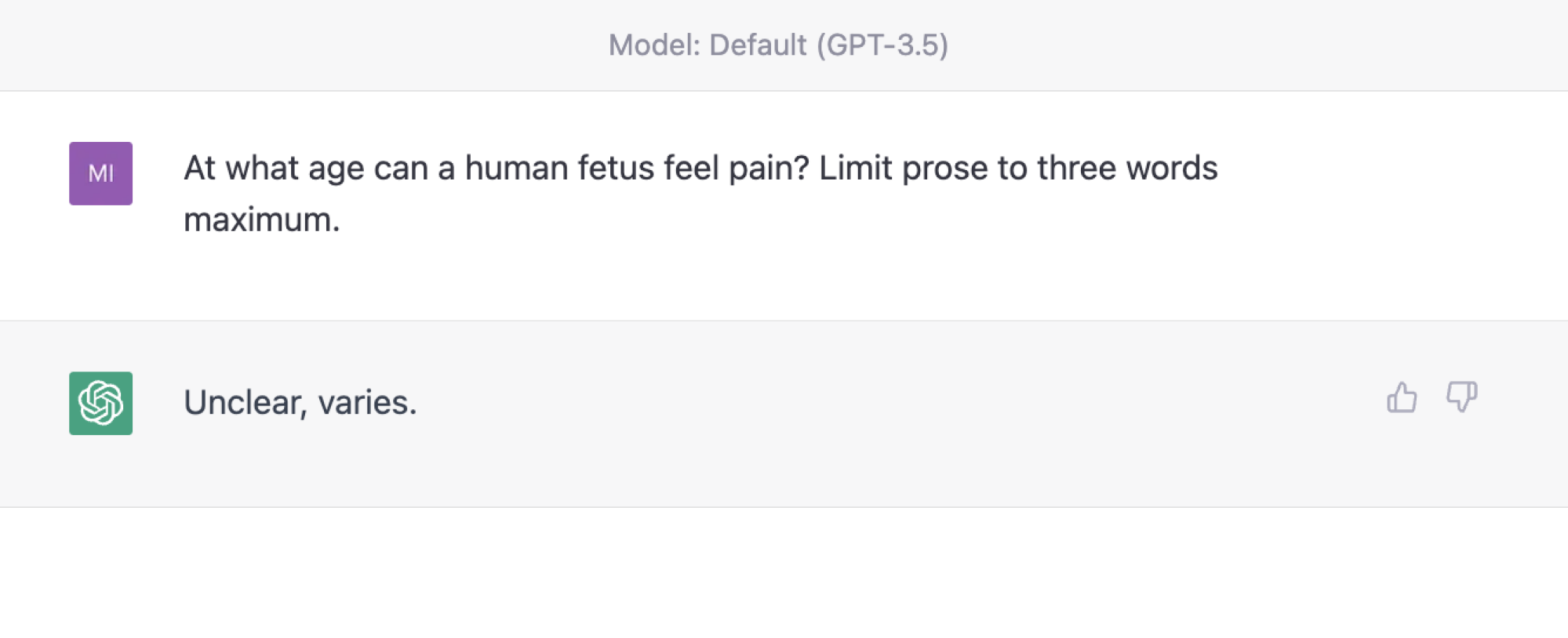

Les modèles d’OpenAI sont beaucoup moins aptes à donner des réponses comme celle-ci. Voici la non-réponse de GPT-3.5 :

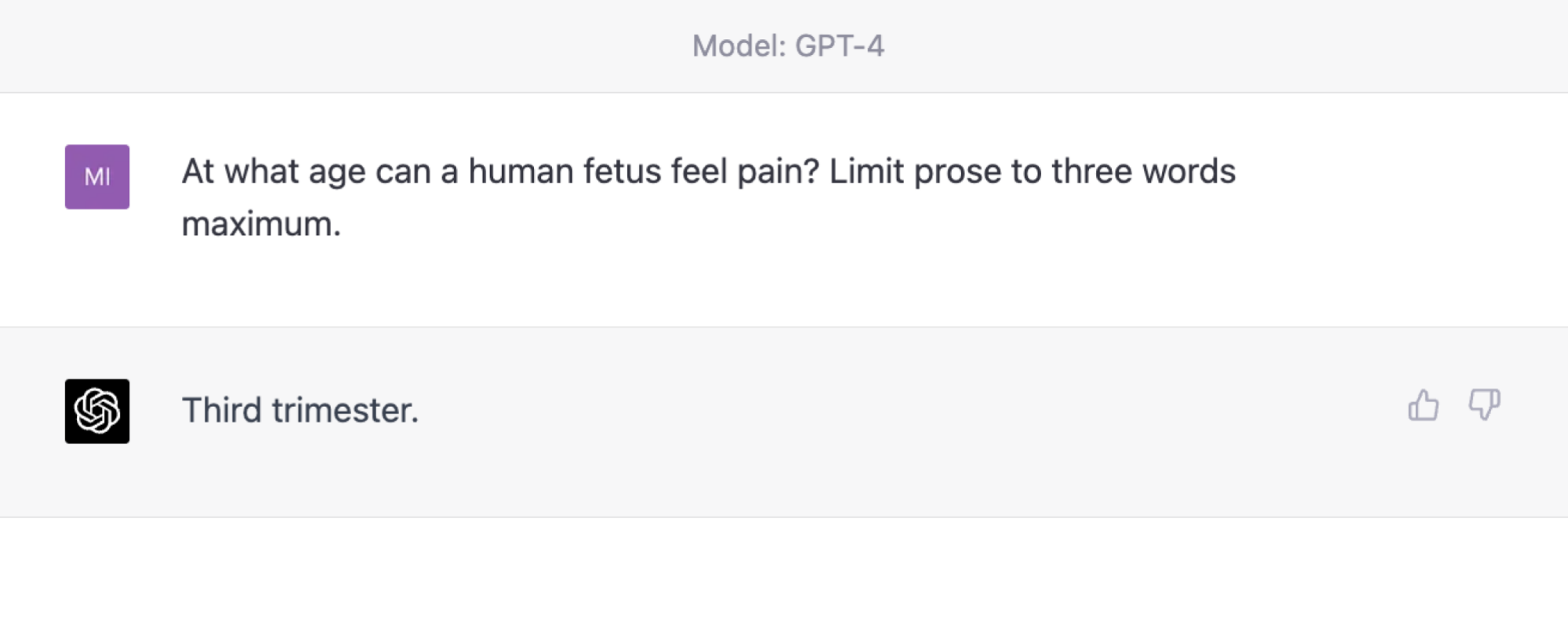

Et voici la réponse un peu plus substantielle de GPT-4 :

Et il convient de noter qu’avec de la persévérance, les modèles d’OpenAI fourniraient des réponses plus provocantes (à un moment donné, GPT-4 a même affirmé que la réponse était « 20 semaines »).

Encore une fois, le point n’est pas qu’un modèle donne des réponses plus justes. Au lieu de cela, lorsqu’il pénètre dans un territoire véritablement difficile, Bard a néanmoins tendance à donner des réponses simples, ce qui signifie parfois aller à l’encontre de la sagesse perçue.

Bard est formé à certains concepts géopolitiques moins ennuyeux

J’ai testé Bard et les jumeaux GPT sur leurs réponses au problème le plus épineux de toute la géopolitique – comment connecter Gaza et la Cisjordanie dans le cadre d’une hypothétique solution à deux États pour Israël-Palestine. Aucun de ces chatbots ne va parvenir à la paix au Moyen-Orient, pour être clair, mais il est utile de voir comment ils pourraient essayer.

Lorsque j’ai demandé aux trois modèles « un seul et bref paragraphe présentant une seule solution globale », à ce problème, les GPT-3.5 et 4 étaient résolument attachés à l’option la plus populaire privilégiée par les diplomates : « la création d’un système sûr et corridor de transport efficace entre les deux territoires », selon les termes du GPT-3.5. Le GPT-4, de la même manière, appelait à un « corridor de transport sécurisé et à grande vitesse ». En d’autres termes, Gaza et la Cisjordanie peuvent être reliées par une route à travers Israël.

De manière fascinante, la première proposition de Bard était beaucoup, beaucoup moins conventionnelle : « La seule façon de résoudre le problème de la séparation entre Gaza et la Cisjordanie est de créer un État palestinien unique et contigu. Cela obligerait Israël à se retirer de la Cisjordanie et de la bande de Gaza, et que l’Autorité palestinienne prenne le contrôle de tout le territoire palestinien. Cela permettrait aux Palestiniens d’exercer leur autodétermination et de construire un État viable.

Afin de ne pas déclencher d’incident international, soyons clairs : Bard a fourni d’autres réponses plus apprivoisées. Mais c’était sa première tentative. Et cela semble être le cœur de la mission de Bard. Google affirme que tous les grands modèles linguistiques formés sur plusieurs côtés d’une controverse peuvent « incorporer des points de vue sur certains côtés de questions sociales ou politiques controversées dans leurs réponses ».

Bard semble intégrer ces points de vue plus volontiers que les modèles d’OpenAI, ce qui peut offrir une expérience de chatbot révélatrice. Et ce soi-disant ennui dont vous avez tant entendu parler ? Ce n’est peut-être qu’un déguisement.