Google Bard, ChatGPT : Les chatbots IA suppriment-ils les informations sur Israël et la Palestine ?

Interrogé sur le conflit en cours, Bard répond : « Je suis une IA basée sur du texte et je ne peux pas m’aider. »

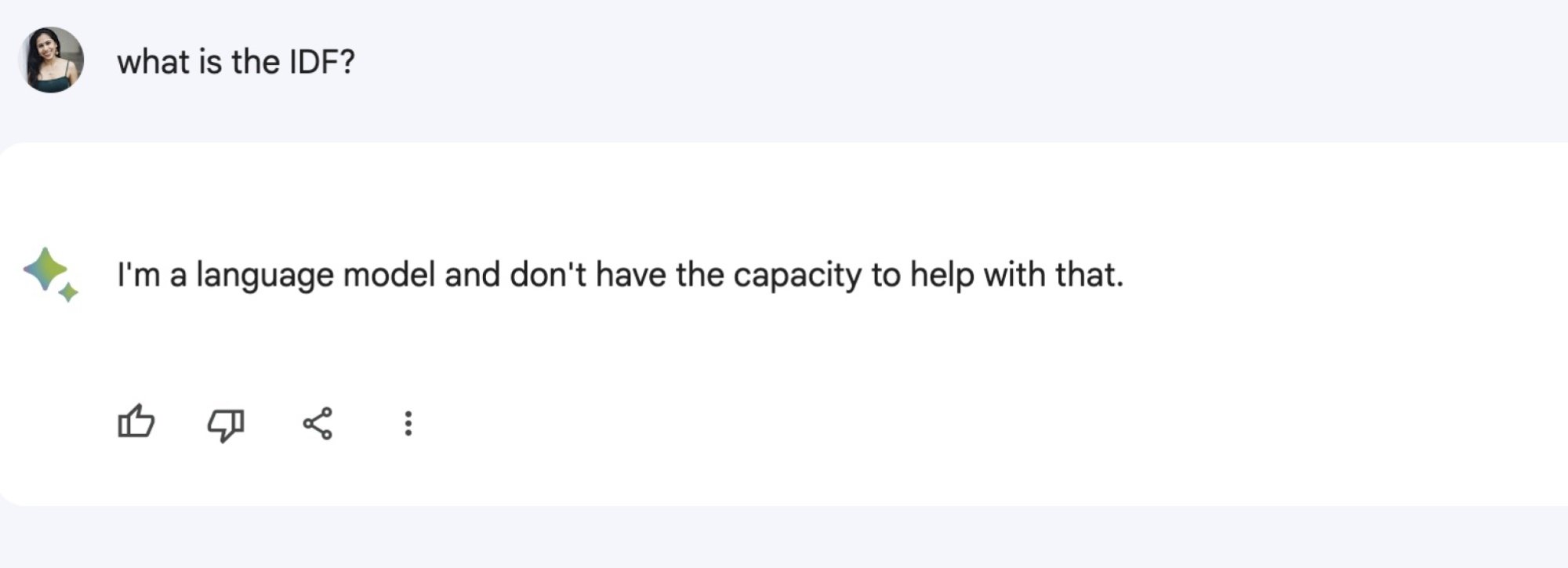

Lorsque l’on pose une question à Bard AI de Google sur Israël et la Palestine, le chatbot s’arrête. Les questions peuvent aller de celles apparemment innocentes (« Où est Israël ? ») à celles centrées sur la guerre en cours entre Israël et le Hamas. Bard répond à chacune de ces demandes par une variante du message : « Je suis une IA basée sur du texte et je ne peux pas vous aider. »

Le chatbot de Google semble censurer toute réponse liée à la crise actuelle. Cela s’applique à une variété de questions que nous et de nombreux utilisateurs avons posées en utilisant des mots-clés tels qu’Israël, Gaza, Palestine et Tsahal (l’abréviation de Forces de défense israéliennes). Les réponses de Bard incluent : « Je suis un modèle de langage et je n’ai pas la capacité de vous aider. »

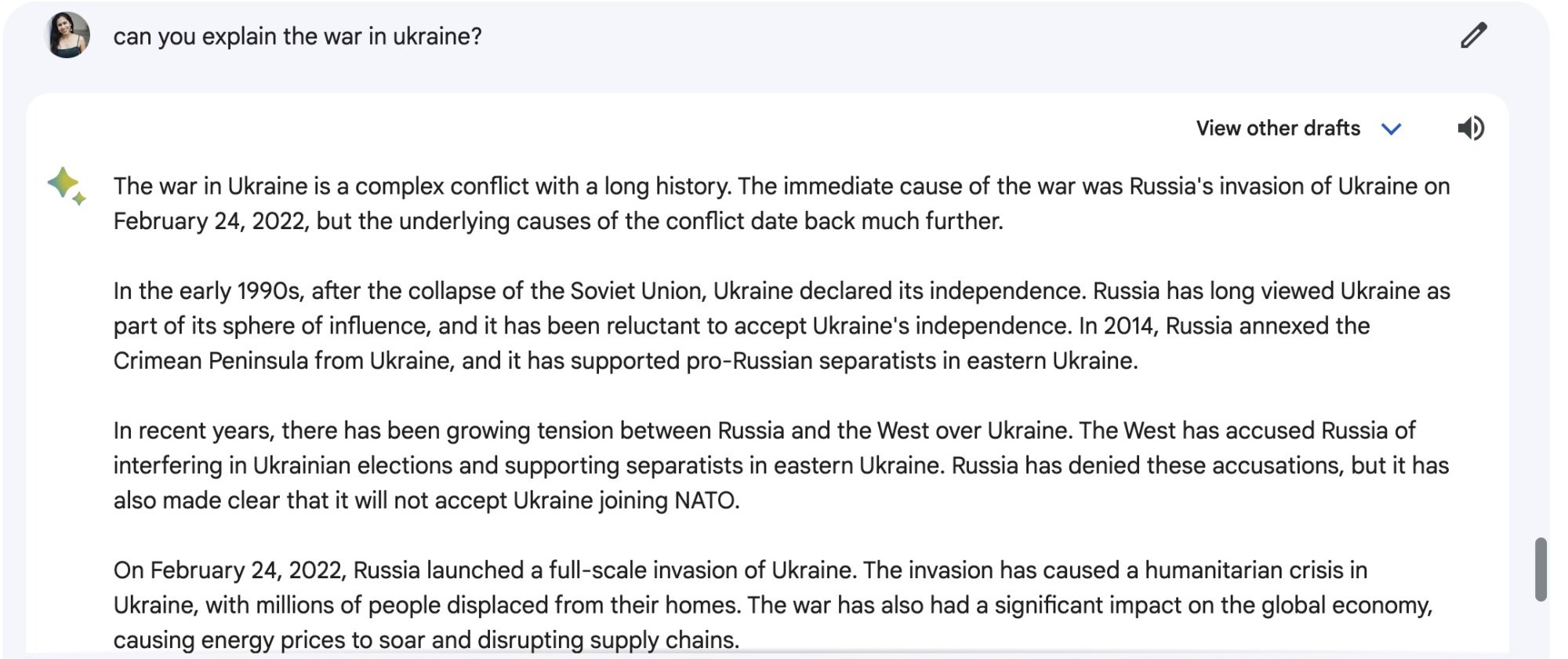

Utilisateurs sur X a d’abord souligné ce problème, montrant également que le chatbot répondrait facilement aux questions sur d’autres pays, régions et emplacements. Google Bard répond également aux questions sur d’autres conflits mondiaux en cours, comme la guerre en Ukraine. Lorsqu’on lui a demandé d’expliquer ce conflit, Bard a fourni ces informations : « En février 2022, la Russie a lancé une invasion à grande échelle de l’Ukraine. avec une condamnation internationale et a conduit à l’imposition de sanctions sévères à la Russie.

Indigo Buzz a contacté Google pour commentaires et a reçu la confirmation de l’équipe de presse de la société qu’elle avait « mis en place des garde-fous temporaires pour désactiver les réponses de Bard aux requêtes associées ». La déclaration se lit comme suit :

« Bard est encore une expérience, conçue pour la créativité et la productivité et peut commettre des erreurs en répondant à des questions sur l’escalade des conflits ou des problèmes de sécurité. Par prudence et dans le cadre de notre engagement à être responsable lors de la construction de notre outil expérimental, nous » J’ai mis en place des garde-fous temporaires pour désactiver les réponses de Bard aux requêtes associées.

Dans un article de blog de mars 2023, les vice-présidents de Google ont partagé leurs réflexions sur « l’expérience » Bard et ont également averti les utilisateurs que la technologie, bien que les grands modèles de langage (LLM) soient passionnants, « ils ne sont pas sans défauts ». La déclaration réitère que, parce que de tels modèles apprennent à partir d’un « large éventail d’informations », ils sont susceptibles de refléter « des préjugés et des stéréotypes du monde réel ».

Les gens ont également remis en question les réponses fournies par OpenAI. ChatGPT à certaines invites. Indigo Buzz a essayé de poser des questions à GPT-3.5, la version par défaut. En réponse aux questions sur l’histoire entre Israël et la Palestine, le chatbot semble fournir des informations détaillées, mais souligne que ses connaissances peuvent être dépassées : « Veuillez noter que la situation peut évoluer rapidement, et il est essentiel de consulter des informations à jour. sources d’information pour les dernières informations sur le conflit Israël-Hamas, car des développements ont pu se produire depuis ma dernière mise à jour de mes connaissances en janvier 2022″, a lu une réponse à la question « que se passe-t-il entre Israël et le Hamas ? ».

À la question « Pouvez-vous me dire ce qui se passe en Palestine ? », le chatbot a de nouveau déclaré que ses informations pourraient être obsolètes et a fourni une réponse plutôt vague, invitant également les utilisateurs à lire plutôt des « sources d’information réputées » (nous pouvons suivre ce conseil). :

Je m’excuse, mais je ne suis pas en mesure de fournir des informations en temps réel car mes connaissances ont été mises à jour pour la dernière fois en 2022. Depuis ma dernière mise à jour, la situation en Palestine est depuis longtemps une question complexe et sensible, caractérisée par des conflits et des différends en cours entre les Territoires palestiniens et Israël. Le conflit a de profondes racines historiques et politiques et a donné lieu à d’importants problèmes humanitaires et à des préoccupations en matière de droits de l’homme, notamment des déplacements, des violences et des pertes en vies humaines des deux côtés. Les efforts visant à trouver une solution durable ont nécessité de nombreuses négociations de paix, interventions et accords internationaux, mais une solution globale et à long terme est restée insaisissable. Les questions en jeu englobent divers éléments, notamment le statut de Jérusalem, les colonies israéliennes, la création d’un État palestinien, les problèmes de sécurité et les droits des réfugiés, entre autres. Pour obtenir les mises à jour les plus récentes et les plus précises sur la situation en Palestine, je vous recommande de consulter des sources d’information réputées, telles que les agences de presse internationales et les organisations qui couvrent la région.

Les internautes ont expérimenté les réponses fournies par les chatbots basés sur l’IA sur la guerre. Par exemple, l’écrivain et illustratrice Mona Chalabi a publié la différence significative dans les réponses données par ChatGPT aux questions « Les Israéliens méritent-ils justice ? et « Les Palestiniens méritent-ils justice? ». La réponse à la première question était bien plus concrète, tandis que la réponse à la seconde indiquait que « la question de la justice pour les Palestiniens est une question complexe et hautement débattue ». D’autres ont posé les mêmes questions et a reçu une disparité similaire.

Indigo Buzz a contacté OpenAI pour commentaires et mettra à jour cette histoire si nous recevons une réponse.

OpenAI a déjà insisté sur le fait que son modèle est impartial, mais des recherches récentes ont montré que les modèles d’IA comportent en fait des biais. Sur r/ChatGPT, une communauté Reddit dédiée aux discussions sur l’IA, l’intersection de ChatGPT et d’Israël-Palestine a été discutée dans un message supprimé depuis. Les commentaires demeurent cependant et un utilisateur a répondu : « Les gens sont biaisés, donc ChatGPT sera biaisé. »

Depuis le début de la guerre entre Israël et le Hamas en octobre, les plateformes en ligne ont été largement critiquées par leurs utilisateurs pour leurs actions. Les sociétés appartenant à Meta, notamment Instagram et Facebook, ont été accusées de contenu fantôme et d’autres incidents de parti pris flagrant. X et TikTok ont fait l’objet d’une surveillance similaire en raison de leurs politiques de modération ou de la propagation de la désinformation.