Microsoft Build 2024 : ce que GPT-4o peut faire sur Azure AI

GPT-4o est désormais disponible sur Azure AI.

Le modèle multimodal GPT-4o d'OpenAI est désormais disponible pour les développeurs sur Azure AI de Microsoft.

Lors de Microsoft Build 2024, la conférence des développeurs de l'entreprise, Microsoft a déclaré que ceux qui souhaitent mettre la main sur GPT-4o peuvent désormais y accéder via Azure AI Studio et en tant qu'API.

Azure AI Studio de Microsoft est un terrain de jeu permettant aux développeurs d'essayer les derniers outils pris en charge par Azure, qui incluent des modèles OpenAI comme GPT-4 Turbo – et maintenant GPT-4o.

Les capacités d'image et de vision de GPT-4o sont déjà disponibles via la propre API d'OpenAI et ChatGPT. Mais le très attendu mode vocal est encore dans quelques semaines. Il en va de même pour l'accès GPT-4o via Azure AI Studio et l'API de Microsoft – pas encore de mode vocal. Le billet de blog du centre de la communauté technologique de Microsoft indique que les capacités audio viendront « dans le futur ».

On ne sait pas si les fonctionnalités audio sont actuellement disponibles via Azure AI, mais le PDG de Microsoft, Satya Nadella, a expliqué certaines façons dont les gens peuvent (éventuellement) utiliser GPT-4o via Copilot. Cela impliquait de partager votre écran ou votre session avec le Copilot alimenté par GPT-4o et de lui demander de l'aide pour jouer à Minecraft. Cependant, comme l'a noté Alex Perry de Indigo Buzz, si vous rencontrez des difficultés avec Minecraft, « vous pouvez soit jouer au jeu pendant 10 minutes, soit simplement le rechercher sur Google ».

Nadella a également expliqué ce que les développeurs peuvent faire avec GPT-4o sur Azure AI.

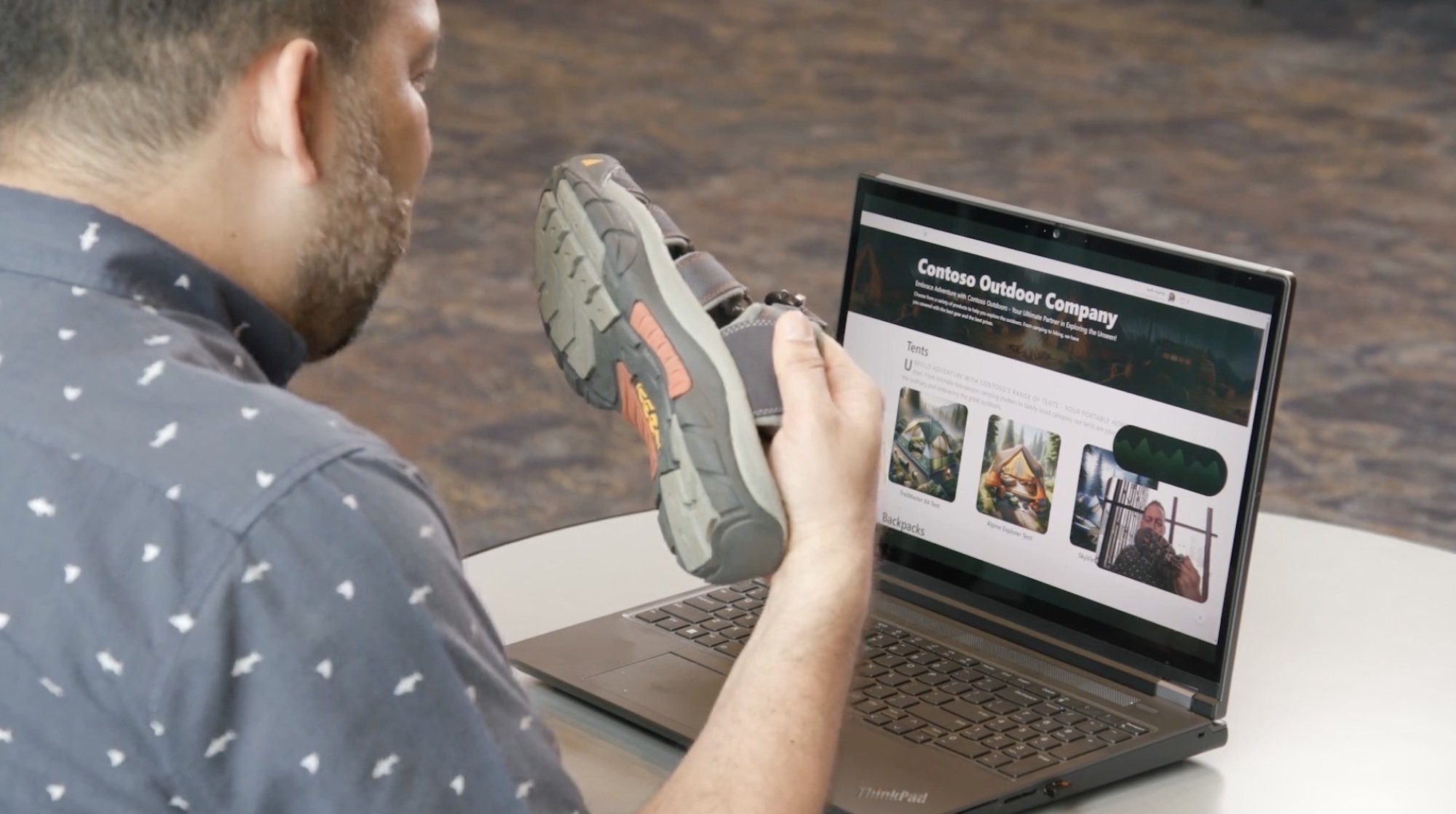

« L'une des choses les plus intéressantes est la façon dont n'importe quelle application, n'importe quel site Web peut être transformé en un canevas conversationnel multimodal full duplex », a déclaré Nadella. Cela signifie que les développeurs peuvent créer des agents qui aident les utilisateurs à naviguer dans les applications et les sites Web. Pour un gars pressé et sur le point de partir en camping pour la nuit, l'agent a montré comment cela pouvait l'aider à choisir les bonnes chaussures et à les ajouter à son panier.

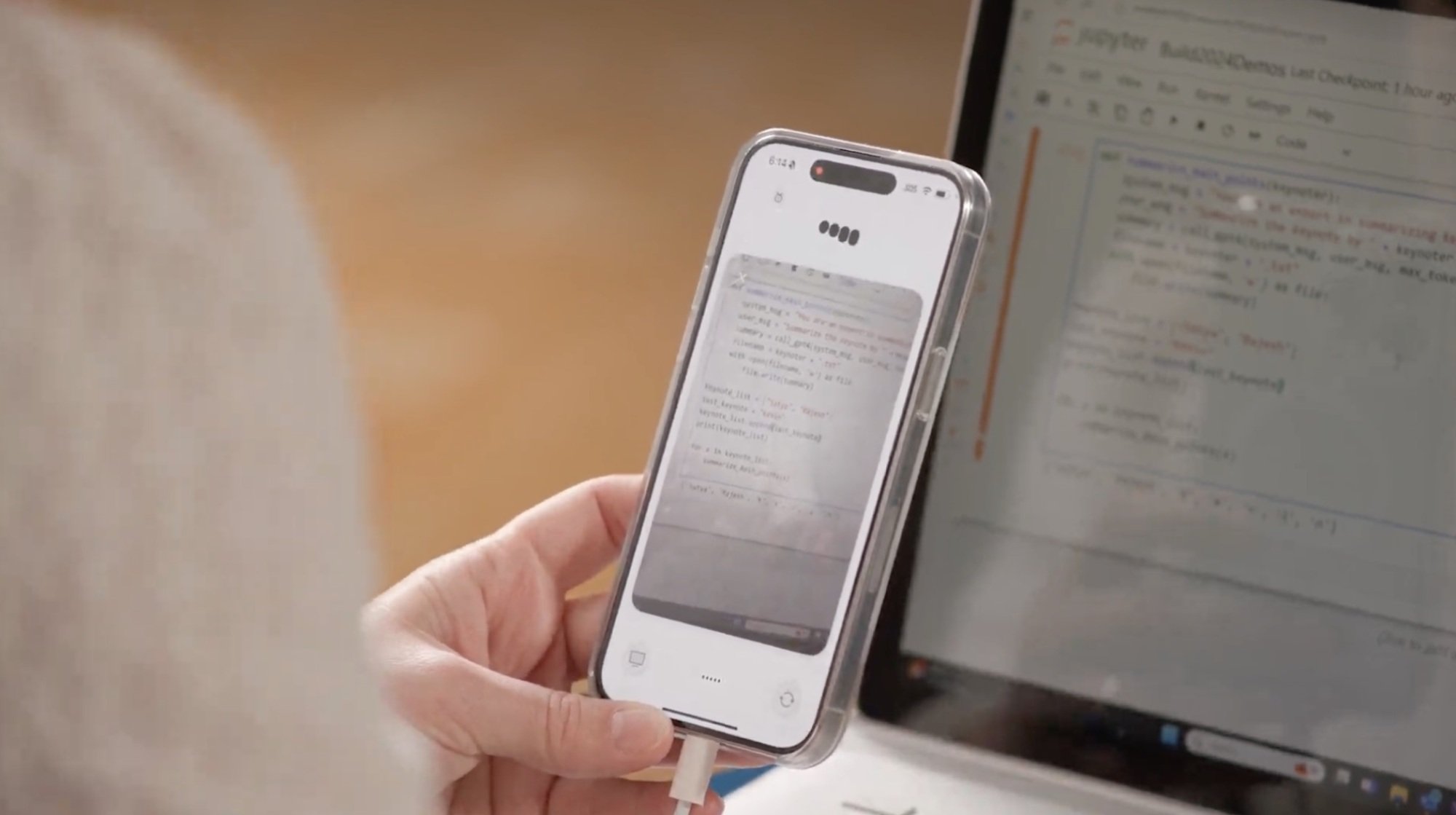

Plus tard dans le discours d'ouverture, Kevin Scott, directeur technique de Microsoft, a montré comment GPT-4o pourrait aider avec le code, soulignant comment les modèles continueront de devenir plus rapides et plus puissants. En pointant son téléphone vers un écran de code, un robot de style ChatGPT utilisant GPT-4o a lu le code et a aidé l'ingénieur principal Jennifer Marsman à résoudre le problème en temps réel.

Lors de Build, Microsoft a saupoudré GPT-4o dans une grande partie de ses annonces, notamment Copilot, Teams, etc. Mais GPT-4o sur Azure AI place le modèle multimodal entre les mains des développeurs, ce qui signifie que de nombreuses applications et outils multimodaux seront certainement à venir.