OpenAI lance le webcrawler GPTBot et des instructions pour le bloquer

Les sites Web peuvent choisir de se retirer.

OpenAI a lancé un robot d’exploration Web pour améliorer les modèles d’intelligence artificielle comme GPT-4.

Appelé GPTBot, le système passe au peigne fin Internet pour former et améliorer les capacités de l’IA. L’utilisation de GPTBot a le potentiel d’améliorer les modèles d’IA existants en ce qui concerne des aspects tels que la précision et la sécurité, selon un article de blog d’OpenAI.

« Les pages Web explorées avec l’agent utilisateur GPTBot peuvent potentiellement être utilisées pour améliorer les futurs modèles et sont filtrées pour supprimer les sources qui nécessitent un accès au mur payant, sont connues pour recueillir des informations personnellement identifiables (PII) ou contiennent du texte qui enfreint nos politiques », lit le poste.

Cependant, les sites Web peuvent choisir de restreindre l’accès au robot d’exploration Web et d’empêcher GPTBot d’accéder à leurs sites, soit partiellement, soit en se désactivant entièrement. OpenAI a déclaré que les opérateurs de sites Web peuvent interdire le crawler en bloquant son adresse IP ou sur le fichier Robots.txt d’un site.

Auparavant, OpenAI a atterri dans l’eau chaude pour la façon dont il collecte des données et pour des choses comme la violation du droit d’auteur et les atteintes à la vie privée. En juin dernier, la plate-forme d’IA a été poursuivie pour avoir « volé » des données personnelles pour former ChatGPT.

Ses fonctions de désactivation n’ont été mises en œuvre que récemment, avec des fonctionnalités telles que la désactivation de l’historique des discussions permettant aux utilisateurs de mieux contrôler les données personnelles accessibles.

ChatGPT 3.5 et 4 ont été formés sur des données et des textes en ligne datant de septembre 2021. Il n’existe actuellement aucun moyen de supprimer du contenu de cet ensemble de données.

Comment empêcher GPTBot d’utiliser le contenu de votre site Web

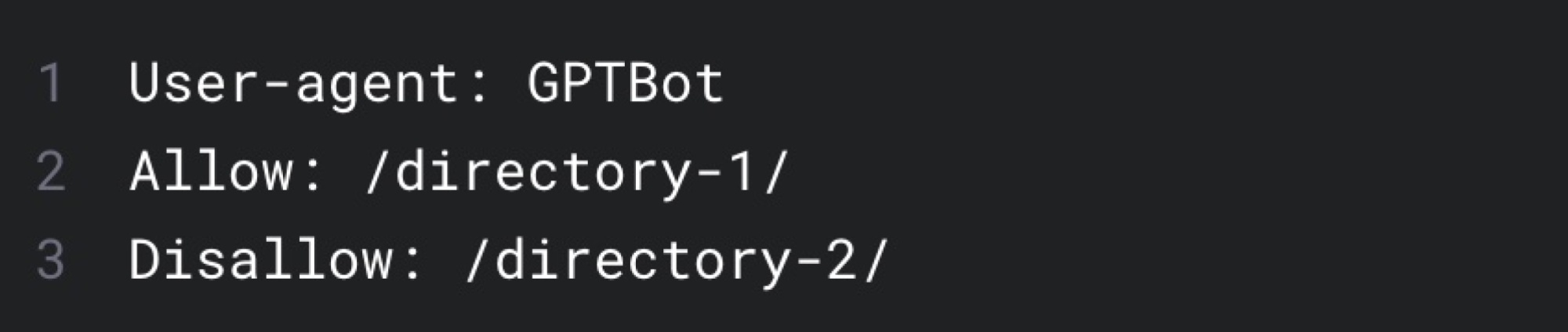

Selon OpenAI, vous pouvez interdire GPTBot en l’ajoutant au Robots.txt de votre site, qui est essentiellement un fichier texte qui indique aux robots Web ce à quoi ils peuvent ou ne peuvent pas accéder à partir d’un site Web.

Vous pouvez également personnaliser les parties qu’un robot d’exploration Web peut utiliser, en autorisant certaines pages et en en interdisant d’autres.