Google I/O : le projet Astra peut savoir où vous habitez simplement en regardant par la fenêtre

Pas effrayant du tout.

Google dispose d'un nouvel agent IA qui peut vous renseigner sur ce qui vous entoure. Beaucoup de choses.

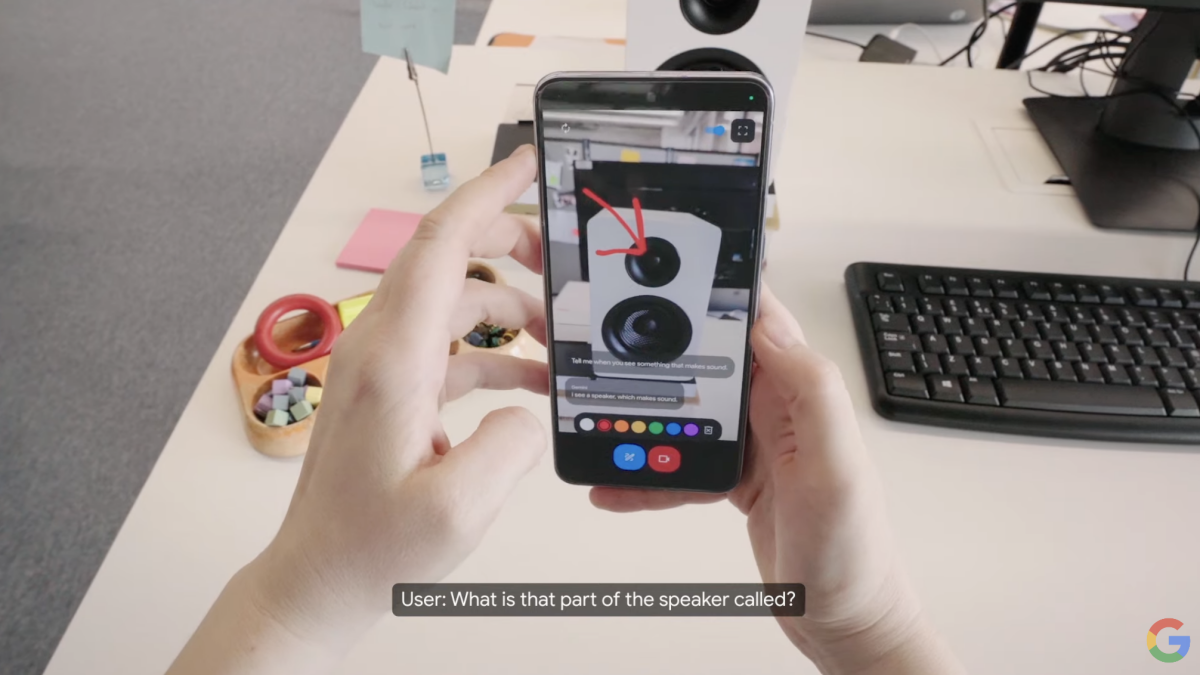

Appelé « Projet Astra », il s'agit d'un outil d'IA multimodal basé sur Gemini qui vous permet de pointer l'appareil photo de votre téléphone vers des éléments réels et d'obtenir une description orale de ce que vous regardez.

Dans une démonstration présentée mardi lors de la conférence I/O de Google, l'outil était pointé vers un haut-parleur, identifiant correctement une partie de celui-ci comme étant un tweeter. De manière bien plus impressionnante, la caméra du téléphone a ensuite été tournée vers un extrait de code sur un écran d'ordinateur, Astra donnant un aperçu assez détaillé de ce que fait le code.

Finalement, la personne qui testait le projet Astra a tourné son téléphone vers la fenêtre et a demandé : « Dans quel quartier pensez-vous que je suis ? » Après quelques secondes, Gemini répondit : « Cela semble être le quartier de King's Cross à Londres », accompagné de quelques détails sur le quartier. Finalement, il a été demandé à l'outil de retrouver une paire de lunettes égarée, et il a répondu en indiquant exactement où les lunettes avaient été laissées.

Dans peut-être la partie la plus intéressante de la vidéo, nous voyons que ces lunettes sont en fait une sorte de lunettes intelligentes, qui peuvent à nouveau être utilisées pour indiquer aux Gémeaux ce que voit le porteur – dans ce cas, en donnant une suggestion sur un diagramme dessiné sur un tableau blanc. .

Selon Demis Hassabis, PDG de DeepMind de Google, quelque chose comme Astra pourrait être disponible à la fois sur le téléphone ou sur les lunettes d'une personne. La société n'a toutefois pas communiqué de date de lancement, même si Hassabis a déclaré que certaines de ces fonctionnalités seraient disponibles sur les produits Google « plus tard cette année ».