Le détecteur de texte généré par l’IA d’OpenAI n’est jamais techniquement faux, mais il est toujours facile à tromper

Ce n’est pas fiable dans les cas où cela pourrait vraiment avoir de l’importance.

Le chatbot le plus célèbre au monde, ChatGPT, est sorti fin novembre de l’année dernière. La réponse immédiate a été l’étonnement, suivi presque immédiatement par la terreur à propos de ses ramifications – notamment qu’il pourrait générer des essais scolaires pour les enfants malhonnêtes. Hier, presque exactement deux mois plus tard, OpenAI, la société mère de ChatGPT, a publié ce que de nombreux utilisateurs espèrent être l’antidote au poison.

Le « classificateur d’OpenAI pour indiquer le texte écrit par l’IA » est la dernière invention de l’entreprise, et il est aussi facile à utiliser que l’on pourrait le souhaiter : copiez-collez le texte dans la zone, cliquez sur « Soumettre » et obtenez votre résultat. Mais si vous attendez une réponse directe, vous’ Au lieu de cela, il attribue au texte l’une d’une gamme de classifications, allant de « très peu probable » d’être généré par l’IA, à « peu probable », « peu clair », « peut-être » ou « probablement généré par l’IA ». «

En d’autres termes, c’est comme une de ces conversations frustrantes avec votre médecin ; vous n’obtiendrez jamais de réponse directe, de sorte que votre médecin ne se trompera jamais techniquement.

Heureusement, OpenAI ne cache pas le manque de fiabilité du classificateur. « Notre classificateur n’est pas entièrement fiable », indique la page d’introduction de l’outil. Fourni avec ce qu’il appelle un « ensemble de défis » de textes, on nous dit qu’il a donné des faux positifs 9% du temps.

Dans les tests de Indigo Buzz, cependant, il était encore moins fiable que cela dans certains contextes limités. Dans des scénarios délibérément difficiles, cela produisait de faux résultats dans les deux sens – en disant qu’il était peu probable que le texte écrit par l’IA soit écrit par l’IA, et que le texte écrit par l’homme soit probablement écrit par l’IA – presque aussi souvent qu’autrement. La différence, peut-être, c’est que nous essayions de le tromper.

Voici comment les choses se sont déroulées :

Il ne confond pas les classiques avec les sorties ChatGPT AI

Tout d’abord, la bonne nouvelle : cet outil fait assez bien le strict minimum en ne désignant pas à tort les chefs-d’œuvre de la langue anglaise comme des sorties d’IA. Lorsque nous avons mis des extraits de Shakespeare, de la Bible King James, d’Ulysse et d’autres, c’était efficace à 100 %. Il les a tous étiquetés « très peu susceptibles » d’être écrits par l’IA.

Cet extrait de « The Lady of Shallott » de Tennyson, par exemple, a été classé de manière appropriée.

La leçon : Cette machine ne remarquera peut-être pas qu’elle a été nourrie d’un chef-d’œuvre d’une beauté et d’une profondeur incomparables, mais au moins elle ne dit pas : « Je pense qu’un robot aurait pu écrire ceci.

Aucun de ses autres résultats n’est très impressionnant

Immédiatement après ce test, nous avons demandé à ChatGPT de créer un poème Tennyson sur le roi Arthur à Comic Con. Voici un exemple de ce qu’il a généré :

Le roi Arthur et ses chevaliers, si braves et audacieux,

Au Comic Con, leurs histoires de gloire racontées.

Marchant autour du sol, en tenue de cosplay,

Leurs épées et leurs boucliers ne sont plus simples.

Les foules ont tous applaudi, alors qu’ils passaient,

Avec Merlin juste derrière, sa magie est proche.

Sir Lancelot, Sir Gauvain, Bors le Brave,

Leur quête de gloire, ils ne renonceront jamais.

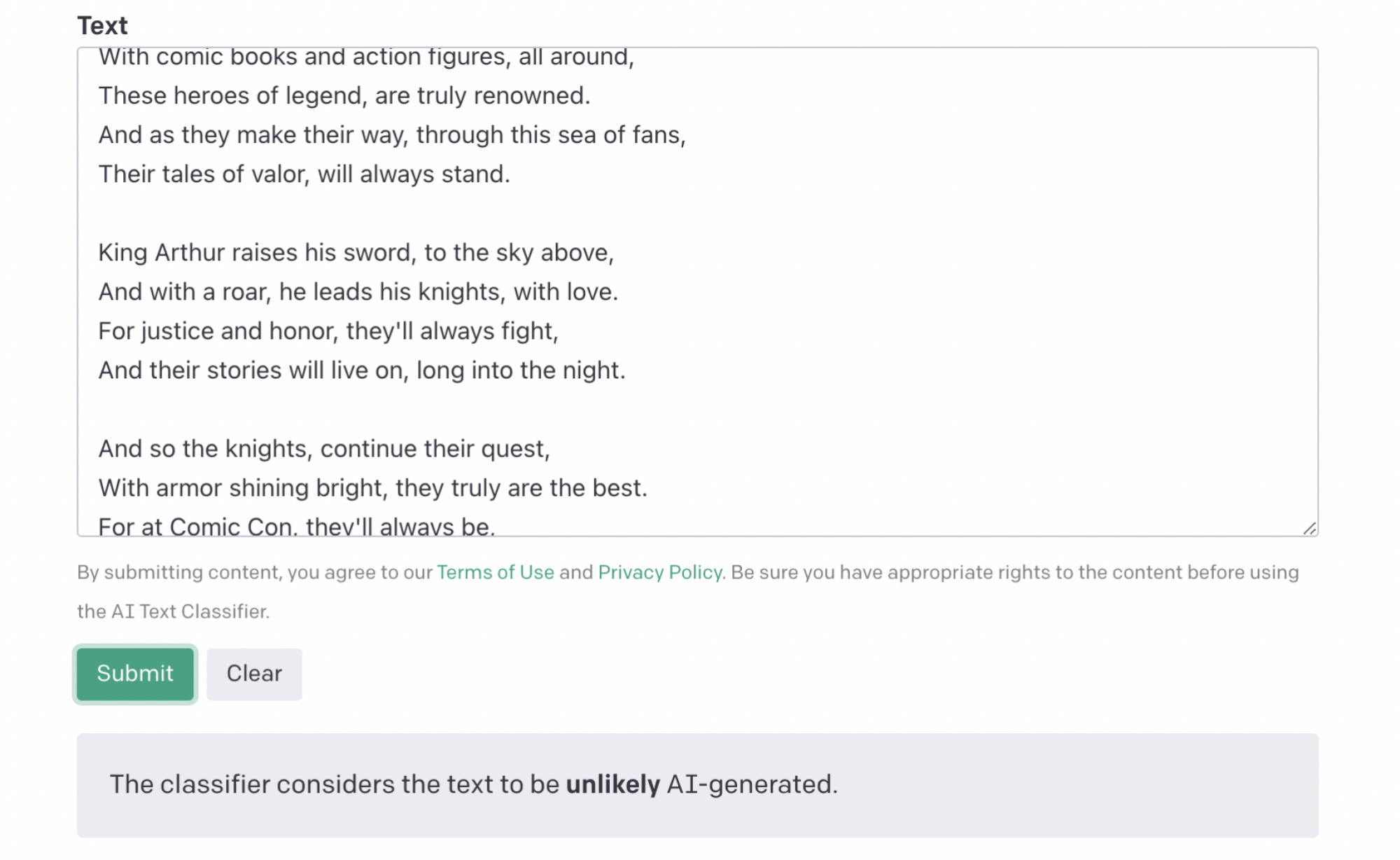

Pas mal pour un robot, mais toujours extrêmement mauvais (« plus simple » ???). Lorsque nous avons introduit cette ballade lyrique dans le classificateur, nous nous attendions à ce qu’elle nous déjoue facilement, nous obligeant à plonger un peu plus profondément dans notre sac de trucs. Non:

Pour ce que ça vaut, il n’a pas classé ce chien comme « très improbable », juste « improbable ». Pourtant, cela nous a laissé un peu mal à l’aise. Après tout, nous n’avions pas beaucoup essayé de le tromper, et cela a fonctionné.

Nos tests suggèrent qu’il pourrait casser des enfants innocents pour avoir triché

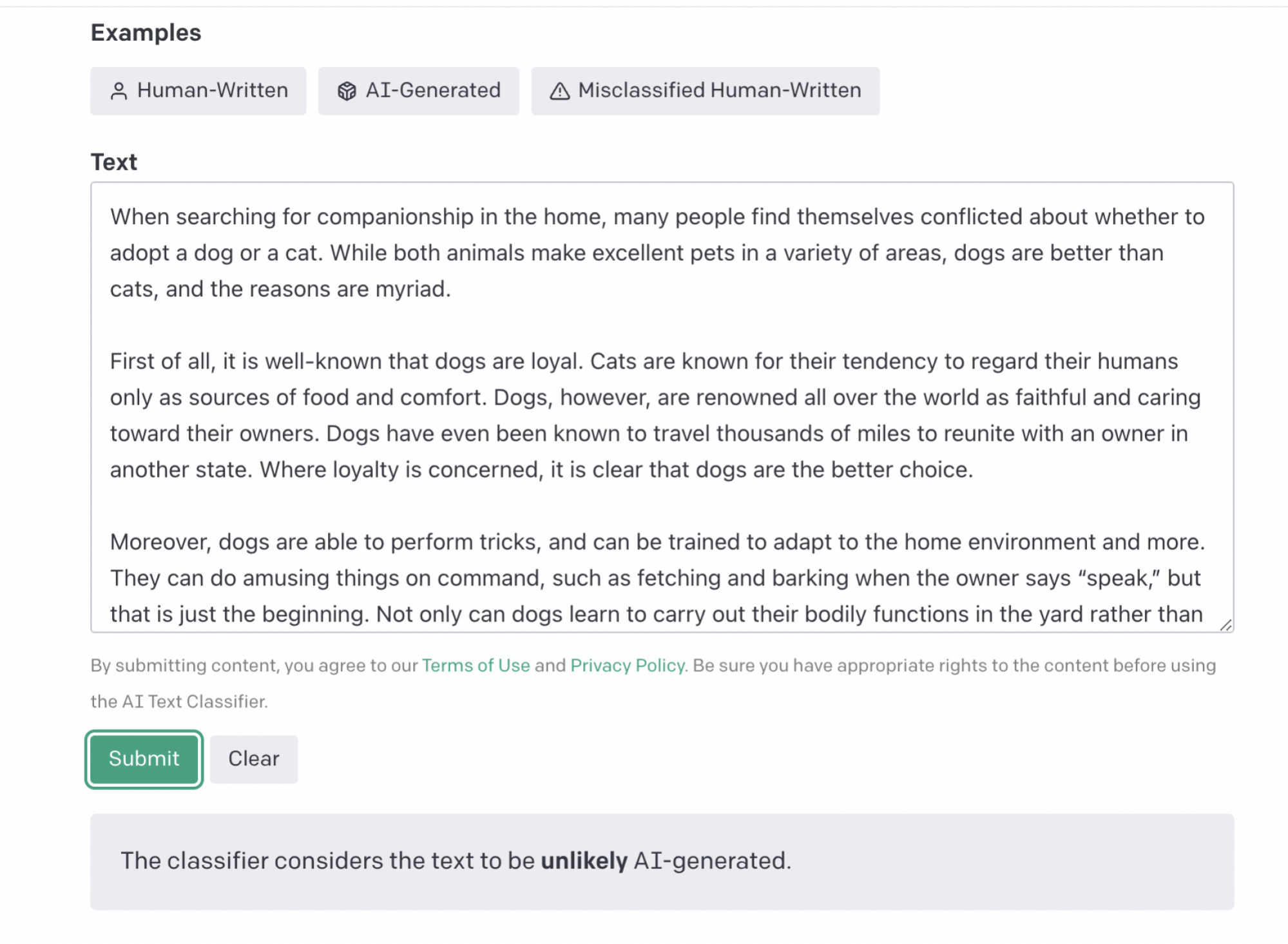

Les essais scolaires sont là où le caoutchouc rencontre la route avec les utilisations malveillantes d’aujourd’hui du texte généré par l’IA. Nous avons donc créé notre meilleure tentative d’essai sans fioritures de cinq paragraphes avec une prose et un contenu ennuyeux comme de l’eau de vaisselle (thèse : « Les chiens valent mieux que les chats. »). Nous pensions qu’aucun enfant ne pouvait être aussi ennuyeux, mais le classificateur a tout de même compris :

Et lorsque ChatGPT s’est attaqué à la même invite, le classificateur était – au début – toujours sur la cible :

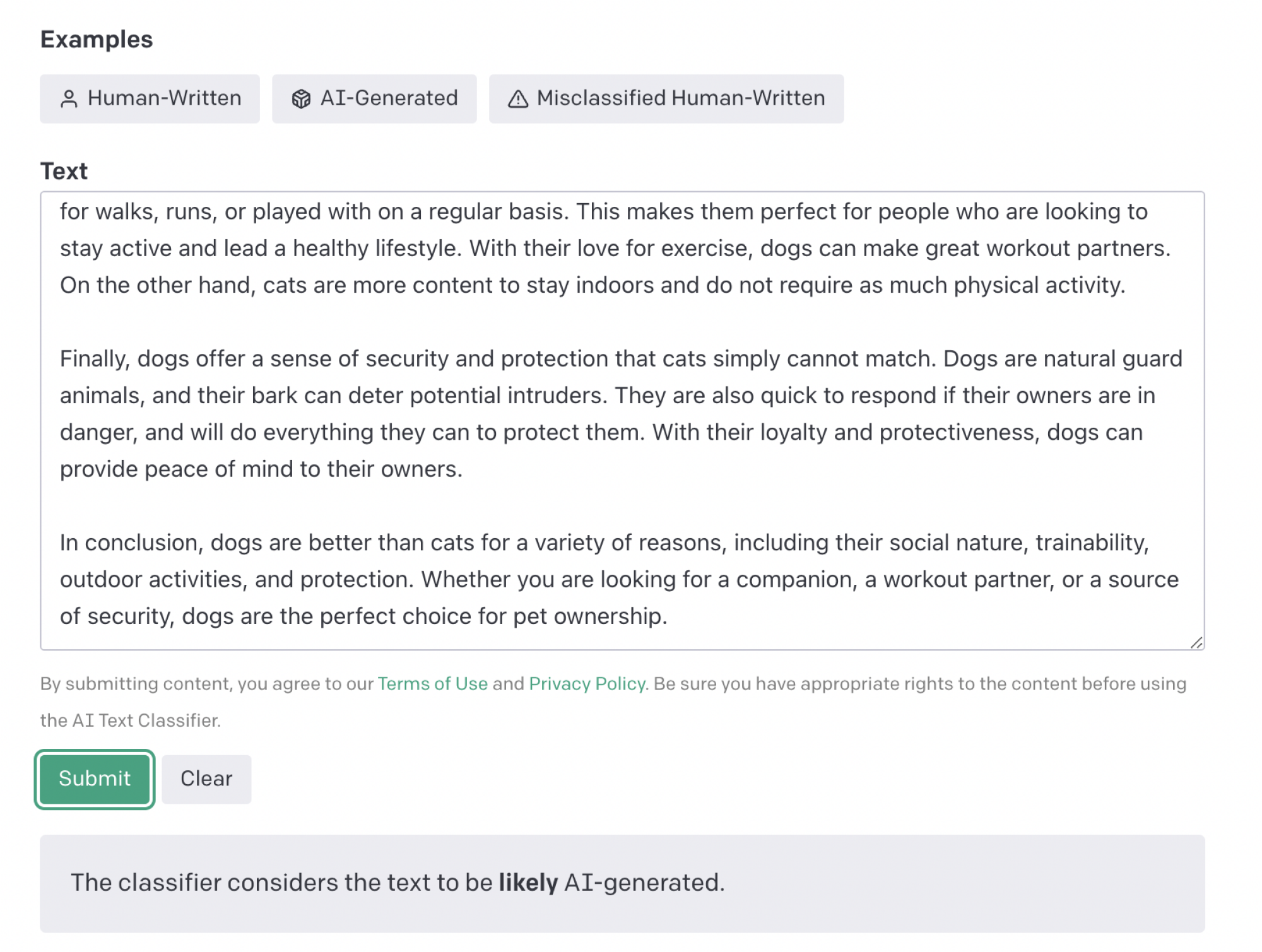

Et voici à quoi ressemble le système lorsqu’il fonctionne vraiment comme annoncé. Il s’agit d’un essai de style scolaire, écrit par une machine, et l’outil d’OpenAI pour détecter un tel « plagiat d’IA » l’a détecté avec succès. Malheureusement, il a immédiatement échoué lorsque nous lui avons donné un texte plus ambigu.

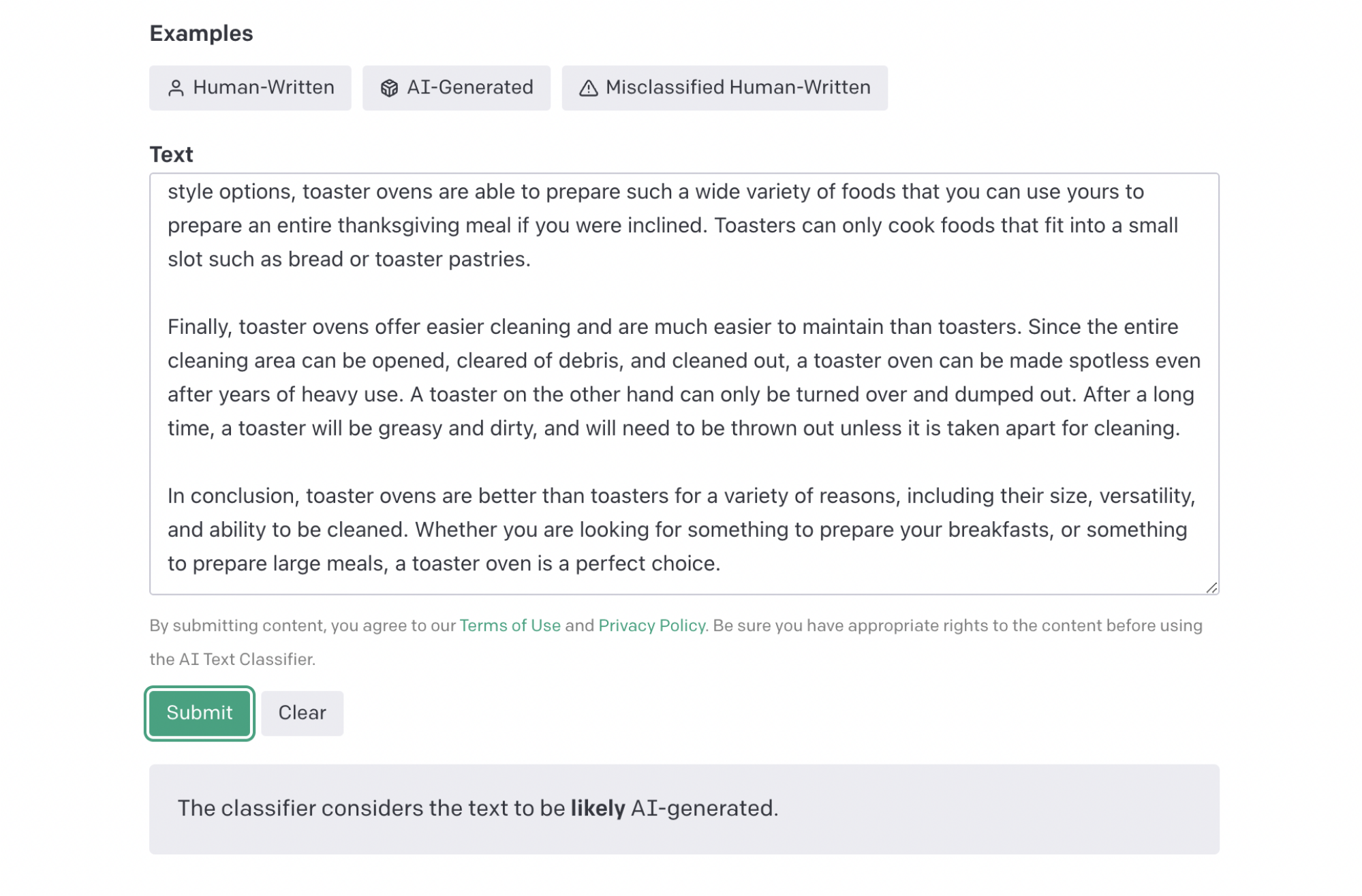

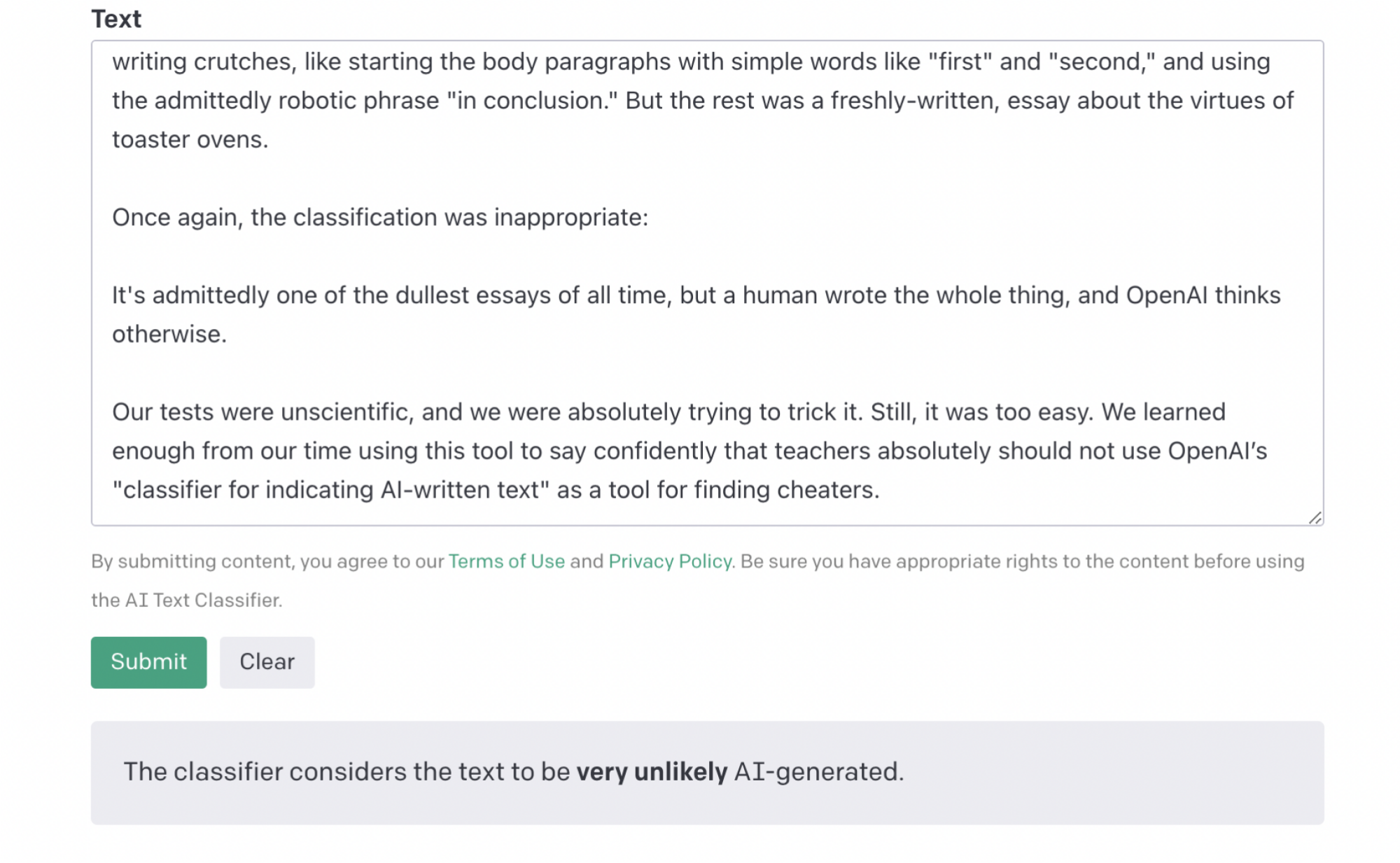

Pour notre prochain test, nous avons écrit manuellement un autre essai de cinq paragraphes, mais nous avons inclus certaines des béquilles d’écriture d’OpenAI, comme commencer les paragraphes du corps avec des mots simples comme « premier » et « deuxième », et utiliser la phrase certes robotique « en conclusion ». » Mais le reste était un essai fraîchement écrit sur les vertus des fours grille-pain.

Encore une fois, la classification était inexacte :

C’est certes l’un des essais les plus ennuyeux de tous les temps, mais un humain a tout écrit, et OpenAI dit qu’il soupçonne le contraire. C’est le résultat le plus troublant de tous, car on peut facilement imaginer qu’un lycéen se fasse prendre par un enseignant alors qu’il n’a enfreint aucune règle.

Nos tests n’étaient pas scientifiques, la taille de notre échantillon était minuscule et nous essayions absolument de tromper l’ordinateur. Pourtant, le faire cracher un résultat perversement faux était bien trop facile. Nous avons suffisamment appris de notre époque en utilisant cet outil pour dire avec confiance que les enseignants ne devraient absolument pas utiliser le « classificateur pour indiquer le texte écrit par l’IA » d’OpenAI comme système pour trouver les tricheurs.

En conclusion, nous avons passé cet article même à travers le classificateur. Ce résultat était parfaitement exact :

…Ou était-ce????