Be My Eyes rencontre GPT-4 : l’IA est-elle la prochaine frontière en matière d’accessibilité ?

Avec l’IA à portée de main, les militants handicapés espèrent abattre les obstacles à l’accès.

À l’approche du 10e anniversaire de la perte de la vue, Lucy Edwards se réapproprie d’innombrables expériences visuelles… avec l’aide de l’intelligence artificielle.

En tant que partenaire de l’application mobile d’assistant visuel Be My EyesEdwards teste les limites de la dernière révélation en matière d’accessibilité, le bénévole virtuel Be My Eyes. L’outil piloté par l’IA agit comme un guide touristique, un blogueur culinaire, un assistant personnel – vous l’appelez – inaugurant une nouvelle forme d’assistance complexe et imitant l’homme en utilisant le modèle de langage d’IA hyperréaliste d’OpenAI. Avec une seule application, le monde entier d’Edwards s’agrandit, selon ses propres conditions.

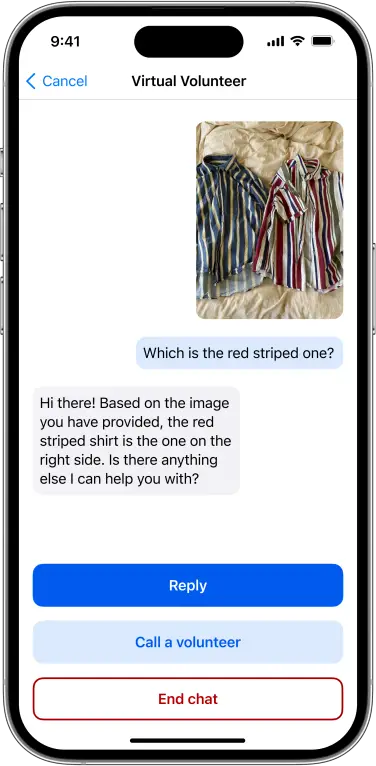

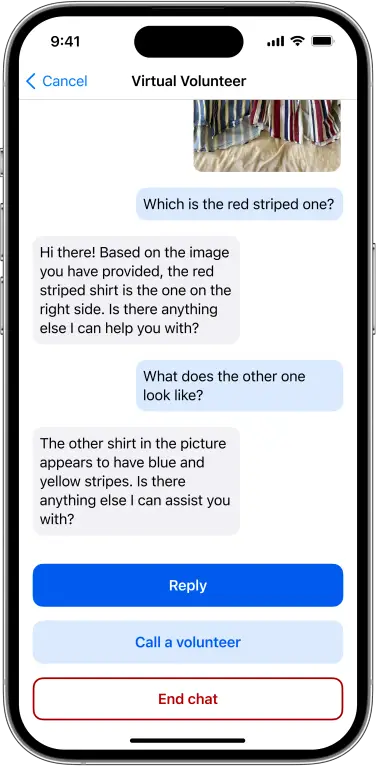

Jusqu’à présent, elle l’a utilisé pour l’aider à lire des catalogues de modetraduisez les ingrédients du chinois vers l’anglais et recherchez des recettes sur le Webécrire un texte alternatif pour les images dans sa propre photothèqueet aidez-la à lire les menus des restaurants. Edwards a également démontré le potentiel de l’utilisation du Volontaire Virtuel comme entraîneur personnel et comme guide pour naviguer dans le métro de Londres.

Edwards elle-même est une créatrice de contenu et militante pour les personnes handicapées connue pour son « Comment fait une fille aveugle » série et style de vie de vlogging de voyage, parmi beaucoup, beaucoup plus. Les millions d’abonnés d’Edwards interagissent avec son contenu alors qu’elle navigue dans un monde conçu de manière inéquitable pour la population voyante, sensibilise à son handicap et découvre des innovations qui changent la vie. Elle a sauté sur l’occasion de tester le nouvel outil, en tant que millénaire autoproclamée férue de technologie.

« J’étais prêt pour l’IA avant même qu’elle n’existe, car je savais ce qui me manquait. Tout Internet pourrait complètement changer pour moi », a déclaré Edwards à Indigo Buzz, « car la majeure partie d’Internet n’est pas accessible en tant qu’utilisateur aveugle. »

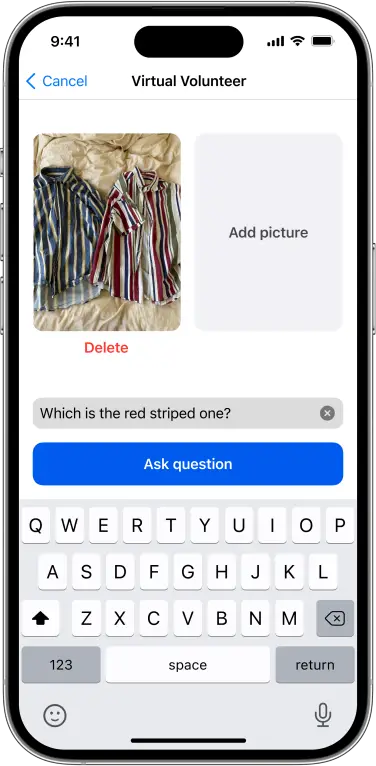

Be My Eyes a été fondée en 2015 pour mettre en relation les utilisateurs aveugles ou malvoyants avec des bénévoles voyants grâce à un système simple d’assistance par chat vidéo en temps réel. Le volontaire virtuel est une extension de ce service fondamental, prenant le cadre d’un logiciel de détection visuelle, utilisé dans des fonctionnalités telles que la détection de porte d’iOS 16, et y ajoutant la complexité linguistique de GPT-4. Ce faisant, l’outil a élargi la quantité d’informations disponibles pour les utilisateurs aveugles et malvoyants d’une manière jamais vue auparavant, ajoutant une sensation de profondeur et une interaction immédiatement individualisée aux outils d’accessibilité.

« De me sentir tellement perdu et bouleversé quand j’ai perdu la vue, à penser maintenant que je pourrais récupérer tout ça, c’est – je ne sais pas, ça me fait pleurer », a déclaré Edwards.

Voir ce post sur Instagram

Surfer sur la vague de battage médiatique de l’IA au-dessus des barrières d’accès

Le nouveau GPT-4 d’OpenAI est tombé sur les genoux d’utilisateurs qui se posaient déjà d’énormes questions sur la place de l’IA dans notre monde : comment protégeons-nous l’intégrité artistique avec les outils d’IA sur le marché ? Dans un monde de désinformation, est-il possible de dire quand l’IA est « l’esprit » derrière quelque chose ? Remplaçons-nous lentement le besoin de compétences humaines et, plus important encore, d’empathie humaine ?

Au milieu de toutes ces préoccupations – et il y en a plusieurs – GPT-4 fait rapidement des vagues technologiques, sa nouvelle version le faisant parallèlement à la revendication du bien social. En plus de son partenariat avec Be My Eyes, OpenAI a mis sa technologie à la disposition d’autres applications d’apprentissage comme la plateforme linguistique Duolingo et chaîne éducative gratuite Khan Academy. GPT-4 a également été introduit dans les lunettes intelligentes Envisionqui permettent aux porteurs d’entendre des descriptions visuelles du monde qui les entoure.

Mike Buckley, PDG de Be My Eyes, a expliqué à Indigo Buzz que le nouvel outil Virtual Volunteer était une extension attendue depuis longtemps et demandée de Be My Eyes, plutôt qu’une refonte à la mode de l’application populaire qui compte un million d’utilisateurs. « Ce n’est pas nécessairement un changement. C’est un ajout », a-t-il déclaré. « Cela répond directement aux personnes aveugles et malvoyantes de notre communauté qui veulent quelque chose comme ça. »

Dans une enquête Be My Eyes auprès d’utilisateurs aveugles et malvoyants, a expliqué Buckley, les commentaires prédominants sur les obstacles à l’utilisation étaient que certains utilisateurs se sentaient mal à l’aise avec l’aspect humain de Be My Eyes. La plupart des répondants ont déclaré qu’ils n’utilisaient pas l’application aussi souvent parce qu’ils « ne veulent pas retirer un bénévole à quelqu’un qui pourrait en avoir davantage besoin », et d’autres ont raconté que c’était parce qu’ils « craignaient d’appeler un étranger ou un agent rémunéré. » Buckley a expliqué que certains craignaient qu’un appel urgent ne soit pas pris à temps, et une partie importante des utilisateurs interrogés ont déclaré que c’était une question d’indépendance, ne voulant pas se sentir dépendant d’un autre bénévole.

« Jusqu’à présent, nous n’avons tout simplement pas vu d’outil technologique qui résoudrait ces besoins assez rapidement et avec suffisamment de précision pour lancer quelque chose comme ça », a-t-il déclaré. Mais la disponibilité publique de ChatGPT et la collaboration avec GPT-4 ont changé cette réalité pour l’entreprise, accélérant un ajout à leurs services.

Quand Edwards a reçu l’appel pour tester la version bêta de l’outil avec d’autres utilisateurs aveugles et malvoyants (qui peuvent toujours postuler pour tester le service), elle raconte qu’elle a encore une fois pleuré. « Je suis une personne tellement autonome. En pensant à l’IA… c’est juste moi et mon téléphone. De bout en bout, c’est moi et la technologie. C’est la véritable autonomie : mon téléphone et moi en harmonie sans aucune autre assistance », a déclaré Edwards. « C’est comme si j’avais retrouvé la vue d’une certaine manière. »

Elle et le reste des testeurs Virtual Volunteer font partie d’un groupe WhatsApp avec les dirigeants de Be My Eyes, fournissant un retour constant 1: 1 sur les succès et les échecs de l’IA. Edwards dit qu’elle signale environ deux à quatre problèmes mineurs chaque jour, mais qu’elle a trouvé cela impressionnant dans l’ensemble.

« Ce n’est pas parfait », a déclaré Buckley, « mais c’est remarquable. »

Que faudra-t-il pour que l’IA gagne la confiance des défenseurs de l’accessibilité ?

Certains en ligne ont exprimé un sentiment de méfiance à l’égard d’un outil d’accessibilité entièrement dirigé par l’IA comme celui-ci, et une grande partie de cela concerne la sécurité et la vérification des faits, d’autant plus que l’application annonce des utilisations réelles dans des situations comme le transport ou le travail.

Buckley a assuré à Indigo Buzz que la précision et la sécurité sont la priorité numéro un pour l’utilisation de l’IA par Be My Eyes. « La raison pour laquelle nous lançons cela dans une petite version bêta et prenons notre temps, c’est que nous voulons voir comment cela fonctionne vraiment dans le monde réel. J’ai probablement fait 1 000 tests moi-même. Notre équipe en a fait des centaines et des centaines d’autres. Je n’avoir pas eu d’hallucination. J’ai essayé de le faire mal agir, mais cela ne veut pas dire que ce sera parfait dans le monde réel.

« Ce que nous avons dit aux bêta-testeurs, c’est que cela ne remplace pas une canne blanche », a déclaré Buckley. « Cela ne remplace pas un chien-guide. Soyez intelligent. Soyez prudent. Soyez prudent. »

Edwards elle-même n’a pas hésité à essayer un outil comme Virtual Volunteer, principalement parce qu’elle a déjà établi une relation de confiance avec Be My Eyes et d’autres entreprises axées sur l’accessibilité. « Je pense que parce qu’ils le font et qu’ils collaborent avec OpenAI, je lui fais davantage confiance. C’est un processus, alors que si c’était juste moi qui allais sur ChatGPT – comme je l’ai fait – je n’y fais pas autant confiance . »

Dans sa forme bêta, le nouveau Volontaire Virtuel a une invite intégrée pour que les utilisateurs se connectent avec un volontaire humain s’ils sentent que l’assistant IA ne fonctionne pas, et l’assistant informera également les utilisateurs quand il n’est pas sûr de ce qu’il regarde exactement . À tout moment, un utilisateur peut passer à l’aide humaine car la fonction d’origine de l’application restera la même, fonctionnant en tandem avec l’assistant IA.

Dans sa synthèse la plus élémentaire, le Volontaire Virtuel n’est pas différent des outils d’assistance visuelle actuels sur le marché, des outils de détection d’Apple aux applications de détection visuelle comme Seeing AI et belvédère. Ce qui est unique, c’est la quantité de commentaires personnalisables que l’on peut obtenir du modèle de langage OpenAI. Plutôt que de lire uniquement des informations textuelles, comme le ferait un lecteur d’écran, ou de décrire en termes basiques l’objet dans le champ visuel d’un utilisateur, le Virtual Volunteer permet aux utilisateurs comme Edwards d’interagir avec une gamme complète de commentaires. Grâce à des capacités de reconnaissance d’image et d’analyse supérieures, les images et le texte reçoivent des descriptions égales, et les utilisateurs peuvent poser des questions de suivi en couches. Le bénévole peut répondre aux invites sur à peu près tout ce qui est capturé et téléchargé avec seulement un appareil photo de téléphone.

« Vous allez voir certains espaces adopter l’IA plus généralement. Je sais qu’il pourrait y avoir des personnes plus âgées, ou des personnes qui ont vu le fonctionnement interne de l’IA, qui pourraient avoir une certaine hésitation. Je ne veux pas saper cela. Mais personnellement, je suis vraiment excité », a déclaré Edwards.

Au-delà des préoccupations techniques liées à l’introduction de l’IA dans cet espace, l’outil soulève la question de la nécessité de l’interaction humaine.

Buckley dit qu’autant d’utilisateurs de Be My Eyes préfèrent les volontaires humains que ceux qui préfèrent les volontaires virtuels, et que le volontaire virtuel est entièrement une question de choix. « Il s’agit de donner à notre communauté les moyens de faire les choix qu’elle veut faire pour résoudre ses besoins et accroître son indépendance. Il s’agit de les servir. C’est pourquoi nous le faisons, et c’est aussi pourquoi c’est gratuit. » Dans une réalité sociale qui désavantage physiquement et financièrement de nombreuses personnes handicapéesles outils d’accessibilité gratuits peuvent changer la vie.

Edwards a expliqué qu’elle utilisait Be My Eyes en conjonction avec d’autres applications d’assistance visuelle, tout comme Buckley le recommande aux autres utilisateurs. En utilisant son chien-guide, Molly, et des outils comme Microsoft Soundscape et l’application d’abonnement payant Aira (qui utilise des bénévoles humains formés professionnellement pour aider les utilisateurs aveugles), Edwards dispose d’une boîte à outils de navigation robuste, qui comprend à la fois des ressources numériques et humaines à utiliser comme elle le souhaite.

« Nous savons que l’IA est puissante, mais elle doit être façonnée, déplacée et encouragée d’une manière que cette communauté possède et répond à ses besoins », a déclaré Buckley.

En gros, l’outil n’est qu’un aspect d’une discussion plus large sur l’innovation technologique, l’accessibilité et la liberté d’Internet. Dans la lutte pour une culture numérique plus accessible, a déclaré Edwards, les outils basés sur l’IA peuvent aider davantage de personnes à sécuriser l’accès en attendant que les entreprises et les leaders de l’industrie fassent enfin le travail eux-mêmes.

« Ce qui me désespérait, c’est que peu importe à quel point je faisais campagne, faisais campagne et faisais campagne, je n’allais jamais faire en sorte que 100% des sites Web de Google soient accessibles aux lecteurs d’écran », a-t-elle expliqué. « Voici un futur possible où cela peut se produire maintenant. Ce n’est que le début, n’est-ce pas ?

Vous voulez plus d’actualités sur la technologie et l’accessibilité livré directement dans votre boîte de réception ? Inscrivez-vous à la newsletter Top Stories de Indigo Buzz aujourd’hui.