Sur quoi Sora a-t-il été formé ? Les créatifs exigent des réponses.

Nous pensons le savoir, mais OpenAI refuse de nous le dire.

Jeudi, OpenAI a encore une fois bouleversé le monde de l’IA avec un modèle de génération vidéo appelé Sora.

Les démos montraient des vidéos photoréalistes avec des détails nets et complexes, basées sur de simples invites textuelles. UN vidéo basé sur l’invite « Réflexions dans la fenêtre d’un train traversant la banlieue de Tokyo », il semblait avoir été filmé sur un téléphone, avec un travail de caméra tremblant et les reflets des passagers du train inclus. Aucune main étrangement déformée en vue.

Le tweet a peut-être été supprimé

Une vidéo de l’invite « Une bande-annonce présentant les aventures d’un homme de l’espace de 30 ans portant un casque de moto tricoté en laine rouge, un ciel bleu, un désert de sel, un style cinématographique, tourné sur un film 35 mm, des couleurs vives » ressemblait à un Christopher Nolan. -Wes Anderson hybride.

Le tweet a peut-être été supprimé

Un autre chiot golden retriever jouant dans la neige a rendu sa fourrure douce et sa neige moelleuse si réaliste que vous pouvez la tendre la main et la toucher.

La question à 7 000 milliards de dollars est la suivante : comment OpenAI a-t-elle réussi à y parvenir ? Nous ne le savons pas réellement car OpenAI n’a pratiquement rien partagé sur ses données de formation. Mais pour créer un modèle aussi avancé, Sora avait besoin de beaucoup de données vidéo, nous pouvons donc supposer qu’il a été formé sur des données vidéo récupérées aux quatre coins d’Internet. Et certains spéculent que les données de formation incluaient des œuvres protégées par le droit d’auteur. OpenAI n’a pas immédiatement répondu à la demande de commentaires sur les données de formation de Sora.

Dans le document technique d’OpenAI, il se concentre en grande partie sur la méthode permettant d’obtenir ces résultats : Sora est un modèle de diffusion qui transforme les données visuelles en « patchs » ou éléments de données que le modèle peut comprendre. Mais il est à peine mentionné d’où proviennent les données visuelles.

OpenAI dit qu’il « s’inspire de grands modèles de langage qui acquièrent des capacités généralistes en s’entraînant sur des données à l’échelle Internet ». La partie incroyablement vague « s’inspirer » est la seule référence évasive à la source des données d’entraînement de Sora. Plus loin dans le document, OpenAI indique que « la formation des systèmes de génération de texte en vidéo nécessite une grande quantité de vidéos avec les légendes de texte correspondantes ». La seule source d’une quantité massive de données visuelles se trouve sur Internet, un autre indice sur l’origine de Sora.

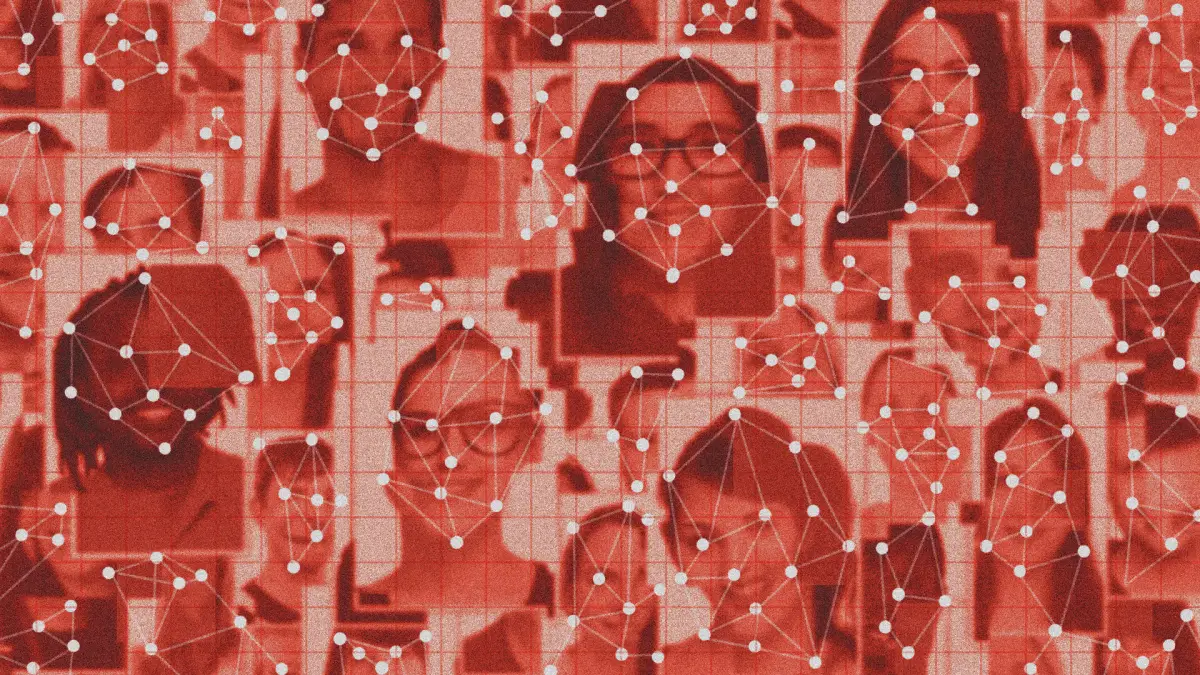

La question juridique et éthique de la manière dont les données de formation sont acquises pour les modèles d’IA existe depuis le lancement de ChatGPT par OpenAI. OpenAI et Google ont été accusés de « voler » des données pour entraîner leurs modèles de langage, c’est-à-dire en utilisant des données récupérées sur les réseaux sociaux, des forums en ligne comme Reddit et Quora, Wikipédia, des bases de données de livres privés et des sites d’information.

Jusqu’à présent, la raison pour laquelle l’intégralité d’Internet est supprimée pour les données de formation est que celles-ci sont accessibles au public. Mais ce qui est accessible au public ne signifie pas toujours domaine public. Par exemple, le New York Times poursuit OpenAI et Microsoft pour violation du droit d’auteur, alléguant que les modèles d’OpenAI utilisaient mot pour mot les travaux du Times ou citaient incorrectement les articles.

Il semble maintenant qu’OpenAI fasse la même chose, mais avec la vidéo. Si tel est le cas, vous pouvez vous attendre à ce que les poids lourds de l’industrie du divertissement aient quelque chose à dire à ce sujet.

Mais le problème demeure : nous ne connaissons toujours pas la source des données d’entraînement de Sora. « L’entreprise (malgré son nom) a été particulièrement discrète sur les sujets sur lesquels elle a formé ses modèles », a écrit Gary Marcus, un expert en IA qui a témoigné lors de l’audition du Comité de surveillance de l’IA du Sénat américain. « Beaucoup de gens ont (supposé) qu’il y a probablement beaucoup de choses là-dedans qui sont générées par des moteurs de jeu comme Unreal. Je ne serais pas du tout surpris s’il y avait également eu beaucoup de formations sur YouTube et divers documents protégés par le droit d’auteur, » » a déclaré Marcus, avant d’ajouter : « Les artistes se font probablement vraiment foutre ici.

Malgré le refus d’OpenAI de divulguer ses secrets, les artistes et les créatifs imaginent le pire. Justine Bateman, cinéaste et conseillère en IA générative de la SAG-AFTRA, n’a pas mâché ses mots. « Chaque nanoseconde de ceci #IA les ordures sont formées sur des œuvres volées par de vrais artistes », a posté Bateman sur X. « Répulsif », a-t-elle ajouté.

Le tweet a peut-être été supprimé

D’autres acteurs des industries créatives s’inquiètent de l’impact de l’essor de Sora et des modèles de génération vidéo sur leur travail. « Je travaille dans le domaine des effets visuels cinématographiques, pratiquement tout le monde que je connais est pessimiste, paniqué et ne sait pas quoi faire maintenant », posté @jimmylanceworth.

OpenAI n’a pas complètement ignoré l’impact explosif que Sora pourrait avoir. Mais cela se concentre en grande partie sur les préjudices potentiels liés aux deepfakes et à la désinformation. Il est actuellement en phase de red-teaming, ce qui signifie qu’il est soumis à des tests de résistance pour détecter les contenus inappropriés et préjudiciables. Vers la fin de son annonce, OpenAI a déclaré qu’elle « engagerait les décideurs politiques, les éducateurs et les artistes du monde entier à comprendre leurs préoccupations et à identifier des cas d’utilisation positifs pour cette nouvelle technologie ».

Mais cela ne résout pas les dommages qui ont pu déjà survenir lors de la création de Sora.